一文上手Tensorflow2.0(四)

本文是全系列中第12 / 23篇:TensorFlow 从入门到精通

- Tensorflow 介绍和安装

- 【干货】史上最全的Tensorflow学习资源汇总

- 文末福利|一文上手TensorFlow2.0(一)

- TensorFlow 卷积神经网络手写数字识别数据集介绍

- 特征工程

- 一文上手最新TensorFlow2.0系列(二)

- 深度学习之激活函数

- Tensorflow实现MNIST手写数字识别

- 一文上手Tensorflow2.0之tf.keras|三

- 卷积神经网络概述

- 损失函数综述

- 一文上手Tensorflow2.0(四)

- TensorFlow 一步一步实现卷积神经网络

- Tensorboard 详解(上篇)

- 深度学习发展史

- Tensorflow从入门到精通之——Tensorflow基本操作

- Tensorboard详解(下篇)

- 卷积的发展历程,原理和基于 TensorFlow 的实现

- 五大经典卷积神经网络介绍:LeNet / AlexNet / GoogLeNet / VGGNet/ ResNet

- TensorFlow 多GPU使用详解

- 一文彻底搞懂BP算法:原理推导+数据演示+项目实战(上篇)

- TensorFlow 实战卷积神经网络之 LeNet

- 深度学习之视频人脸识别系列二:人脸检测与对齐

【磐创AI导读】:本系列文章介绍了与tensorflow的相关知识,包括其介绍、安装及使用等。本篇文章是本系列文章的最后一篇。查看上篇:一文上手Tensorflow2.0之tf.keras|三。在文末作者给出了答疑群的二维码,有疑问的读者可以进群提问。想要获取更多的机器学习、深度学习资源,欢迎大家点击上方蓝字关注我们的公众号:磐创AI。

-

Tensorflow2.0 介绍 -

Tensorflow 常见基本概念 -

从1.x 到2.0 的变化 -

Tensorflow2.0 的架构 -

Tensorflow2.0 的安装(CPU和GPU) -

Tensorflow2.0 使用 -

“tf.data” API -

“tf.keras”API

-

使用GPU加速 -

安装配置GPU环境 -

使用Tensorflow-GPU

4 使用GPU加速

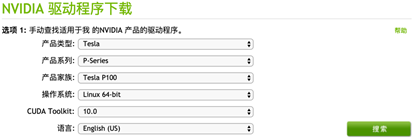

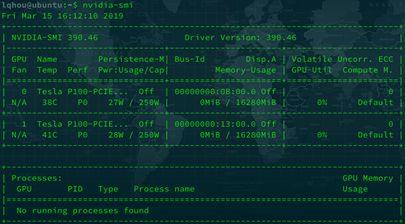

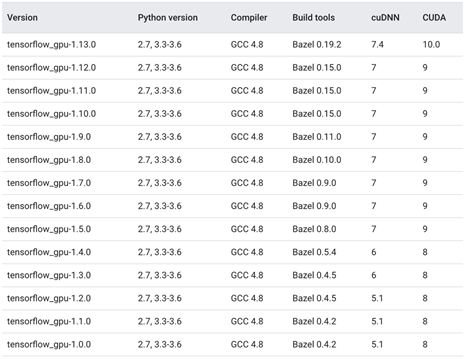

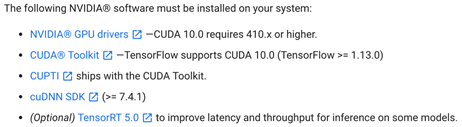

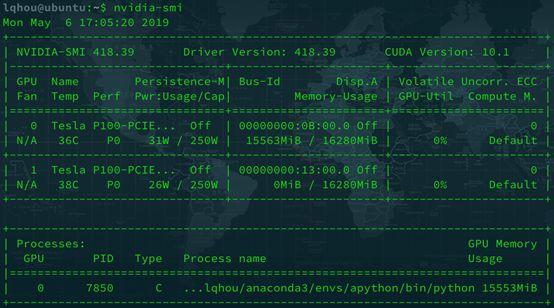

4.1 安装配置GPU环境

apip install tensorflow-gpu==2.0.0-alpha0from tensorflow.python.client import device_lib

def get_available_gpus():

local_device_protos = device_lib.list_local_devices()

return [x.name for x in local_device_protos if x.device_type == 'GPU']

print(get_available_gpus())

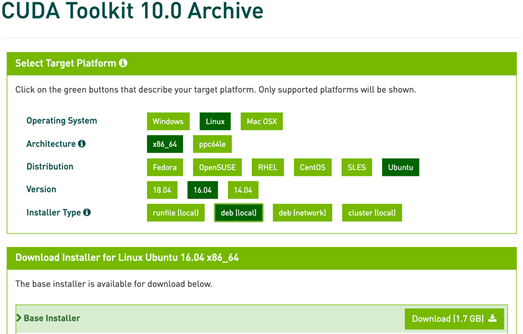

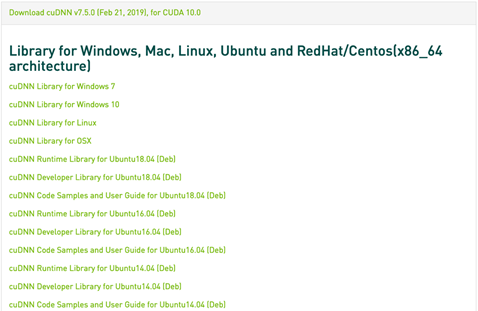

sudo dpkg -i cuda-repo-ubuntu1604-10-0-local-10.0.130-410.48_1.0-1_amd64.deb第二步:添加kay

sudo apt-key add /var/cuda-repo-10-0-local-10.0.130-410.48/7fa2af80.pubupdatesudo apt-get update

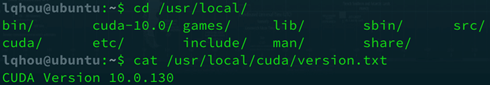

sudo apt-get install cuda-10.0安装完成后,在“/usr/local”目录下会生成“cuda”和“cuda-10.0”两个文件夹,如图8所示,我们可以使用命令“cat/usr/local/cuda/version.txt”查看CUDA版本。

export PATH=/usr/local/cuda-10.0/bin${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda-10.0/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}第五步:验证安装是否成功在终端执行命令“source ~/.bashrc”让环境变量生效。

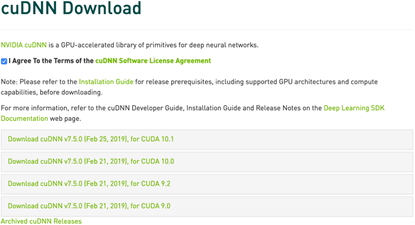

tar zxvf cudnn-10.0-linux-x64-v7.5.0.56.tgzsudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*到这里TensorFlow2.0的GPU版就安装配置完成了。

4.2 使用TensorFlow-GPU

import tensorflow as tf

import os

# 选择编号为0的GPU

os.environ["CUDA_VISIBLE_DEVICES"] = "0"

# 创建模型

model = tf.keras.Sequential()

model.add(layers.Dense(16, activation='relu', input_shape=(10,)))

model.add(layers.Dense(1, activation='sigmoid'))

# 设置目标函数和学习率

optimizer = tf.keras.optimizers.SGD(0.2)

# 编译模型

model.compile(loss='binary_crossentropy', optimizer=optimizer)

# 输出模型概况

model.summary()

import tensorflow as tf

from tensorflow.keras import layers

strategy = tf.distribute.MirroredStrategy()

# 优化器以及模型的构建和编译必须嵌套在“scope()”中

with strategy.scope():

model = tf.keras.Sequential()

model.add(layers.Dense(16, activation='relu', input_shape=(10,)))

model.add(layers.Dense(1, activation='sigmoid'))

optimizer = tf.keras.optimizers.SGD(0.2)

model.compile(loss='binary_crossentropy', optimizer=optimizer)

model.summary()小结

留言送书福利

/ 今日赠送书籍 /

《神经网络与深度学习实战》

/ 今日留言主题 /

原创文章,作者:fendouai,如若转载,请注明出处:https://panchuang.net/2019/08/20/37bce4db7c/

点击下方

点击下方