文末福利|一文上手TensorFlow2.0(一)

本文是全系列中第3 / 23篇:TensorFlow 从入门到精通

- Tensorflow 介绍和安装

- 【干货】史上最全的Tensorflow学习资源汇总

- 文末福利|一文上手TensorFlow2.0(一)

- TensorFlow 卷积神经网络手写数字识别数据集介绍

- 特征工程

- 一文上手最新TensorFlow2.0系列(二)

- 深度学习之激活函数

- Tensorflow实现MNIST手写数字识别

- 一文上手Tensorflow2.0之tf.keras|三

- 卷积神经网络概述

- 损失函数综述

- 一文上手Tensorflow2.0(四)

- TensorFlow 一步一步实现卷积神经网络

- Tensorboard 详解(上篇)

- 深度学习发展史

- Tensorflow从入门到精通之——Tensorflow基本操作

- Tensorboard详解(下篇)

- 卷积的发展历程,原理和基于 TensorFlow 的实现

- 五大经典卷积神经网络介绍:LeNet / AlexNet / GoogLeNet / VGGNet/ ResNet

- TensorFlow 多GPU使用详解

- 一文彻底搞懂BP算法:原理推导+数据演示+项目实战(上篇)

- TensorFlow 实战卷积神经网络之 LeNet

- 深度学习之视频人脸识别系列二:人脸检测与对齐

编辑 | 安可

出品 | 磐创AI技术团队

-

Tensorflow2.0 介绍 -

Tensorflow 常见基本概念 -

从1.x 到2.0 的变化 -

Tensorflow2.0 的架构 -

Tensorflow2.0 的安装(CPU和GPU) - Tensorflow2.0 的使用

-

使用 GPU 加速

1. TensorFlow2.0 介绍

1.1 TensorFlow常见基本概念

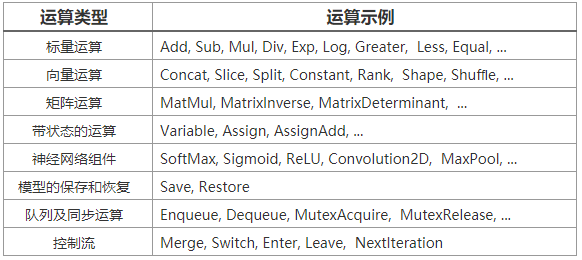

表2-1 TensorFlow的部分运算操作

表2-1 TensorFlow的部分运算操作-

数据类型(同一个张量中的每个元素都具有相同的数据类型,例如float32、int32以及string)

-

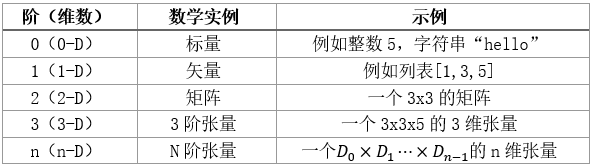

形状(即张量的维数以及每个维度的大小)

表2-2所示是张量的形状示例。

-

tf.Variable(变量,TensorFlow中的张量一般都不会被持久化保存,参与一次运算操作后就会被丢弃了。变量(variable)是一种特殊的运算操作,它可以将一些需要持久化保存的张量存储在内存或显存中,并会返回一个可以对该变量所引用的张量进行一系列特定操作的句柄,例如Assign和AssignAdd(等同于“+=”)等。模型的参数是保存在变量中的,在模型的训练过程中,参数在不断地更新。变量的值可以修改,但是维度不可以变。)

-

tf.constant(常量,常量定义时必须初始化值,且定义后其值和维度不可再改变。)

-

tf.placeholder(占位符,在执行“session.run()”方法时传入具体的值,TensorFlow2.0中不再使用,但依然可以在“tensorflow.compat.v1”模块中找到。)

-

tf.SparseTensor(稀疏张量)

1.2 从1.x到2.0的变化

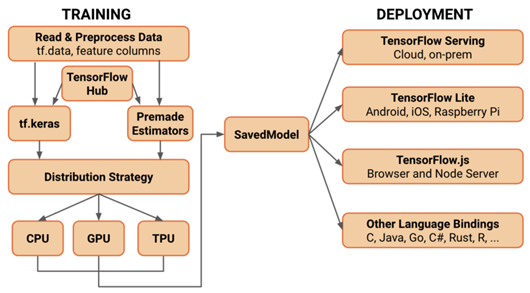

1.3 TensorFlow2.0的架构

留言送书福利

原创文章,作者:fendouai,如若转载,请注明出处:https://panchuang.net/2019/08/20/f7a5f35434/

点击下方

点击下方