在这篇文章中,我将分享关于人体姿势估计的优秀论文的总结。本文主要研究单姿态和多姿态估计问题。希望你会发现它提供了丰富的信息。

单泊估计

1.DeepPose:基于深度神经网络的人体姿态估计:Toshev et。艾尔。和Szegdy et.艾尔。将DeepPose作为一种实用的深度学习方法应用于人体姿态估计。本文将姿态估计方法设计为基于CNN的回归模型来估计人体关节关键点。在这里,使用基于级联CNN的回归方法来重新调整身体关节的关键部位。基于CNN的回归模型也可以估计某些隐藏的人体关节,是一种有效的方法。

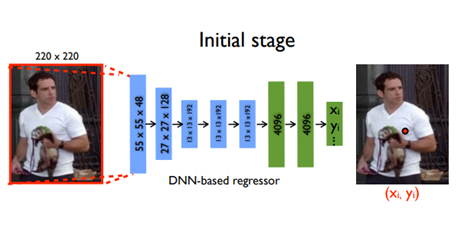

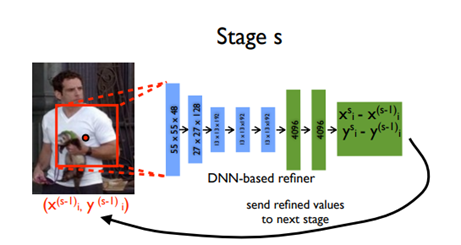

模型的功能:DeepPose模型的功能分别如图5和图6所示。图5显示了使用CNN的第一阶段回归模型。图6示出了使用CNN的第二阶段回归模型。该模型的一个重要特点是,利用级联回归反馈系统对关键点进行细化。在模型的第一阶段,具体关键点被估计为粗调。在预测关节周围裁剪关键点估计图像,并将其作为下一阶段的输入,用于对估计姿势进行微调。

评价参数:以正确率(PCP)作为评价参数。

使用的数据集:LSP和FLIC

测试结果讨论:3级DeepPose给出的上臂和下臂的正确率分别为0.56和0.38。上腿和小腿的最大PCP分别达到0.78和0.71。平均正确率达到0.61。

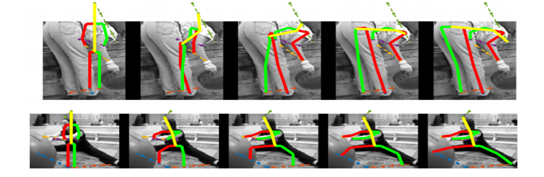

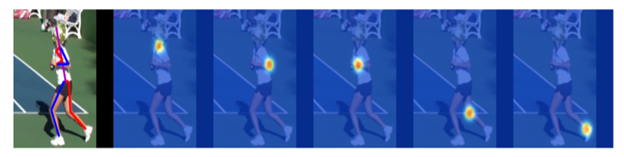

2.带迭代误差反馈的人体姿态估计:Joao等人,Pulkit et.al.、卡特琳娜等人(Katerina et.)艾尔。和Jitendra et.艾尔。表示此ConvNet迭代误差反馈模型。卷积网络(ConvNets)已被用于对各种分类任务使用前馈处理来顺序地提取其特征。使用多层层次结构通过ConvNets表示图像。提供了对输入和输出的结构2D建模的遗传框架。在反馈中使用了自上而下的方法。网络不会直接预测结果,而是会先估计误差,然后通过迭代的方式重新训练到期望的阈值。该模型共对17个关键点进行了标注。

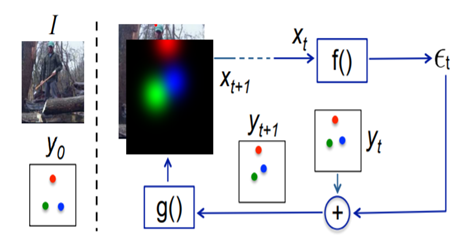

模型的功能:迭代反馈模型及其机制如图7和图8所示。当图像I被送入网络时,它将估计2D点集中的一些关键点Y0。该模型按照图中的函数f作为ConvNet来处理几个方程。函数g将每个关键点位置转换成一个高斯热图。该模型可以通过人体关节空间构形和图像进行学习。

ConvNet架构是在ImageNet上预先训练的。对第一卷积层的17个关键点的滤光片进行了修改。Conv-1层有20个不同的输入通道,其中3个是ImageNet,具有预先训练的权重,其余17个通道由方差为0.1的高斯噪声初始化。该模型在遮挡图像和可见光图像上都进行了训练。为了得到遮挡点,将反向传播梯度置为零。然后,通过ConvNet和高斯滤波器使这些点可见。

评价参数:以正确关键点百分比(PCKh)作为评价参数。

使用的数据集:LSP和MP-II

测试结果表明:IEF对头部和肩部检测的最高准确率分别为95.5和91.6,对上半身和全身的预测准确率分别为81.9和81.3。

3.用于人体姿态估计的堆栈沙漏网络:Alenjandro et。al.、开宇等人。艾尔。和Jian et.艾尔。表示这种独特的模型,它是扩展的跳过网,称为堆栈沙漏网络。单个沙漏网络由多个沙漏网络端到端连续放置在一起。同时采用自上而下和自下而上的方法。该模块在与完全连接的CNN和其他设计层紧密堆叠之前,处理不同尺度的空间信息以进行密度预测。

模型的功能:单个管道与跳跃层一起使用,以保留每个单一分辨率下的空间信息。当要素达到最低分辨率时,通过卷积图层和最大值合并的方法,网络开始自上而下的方法,这是一系列不同尺度上的上采样和不同的特征组合。当标准卷积层应用大型滤波器时,网络性能有所提高。

评价参数:以正确关键点百分比(PCKh)作为评价参数。

使用的数据集:FLIC和MP-II

实验结果表明:该模型对头部和肩部的预测准确率最高,分别为98.2和96.3,对踝关节的预测准确率最低,对MP-II人体姿势的预测准确率最低,为83.6。在FLIC数据集上,肘部正确率达到99%,手腕正确率达到97%。

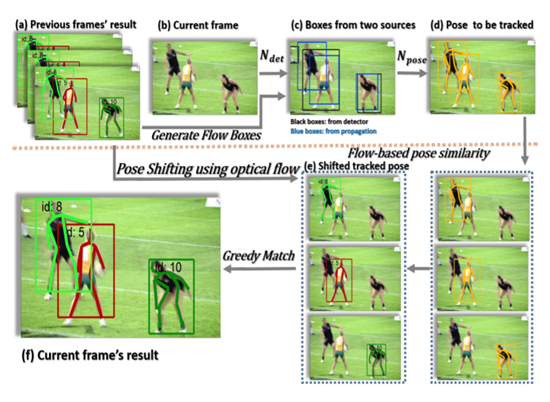

4.简单的人体姿态估计和跟踪基线:bin et。al.、海平等人。艾尔。和宜晨等人(Yichen et.)艾尔。表示了一个模型,该模型是一个具有ResNet的网络,末端只有很少的反卷积层。均方误差被用作预测热图和目标热图之间的损失。目标热图是通过使用2D高斯过滤器生成的。他们的模型结合了反卷积层中的上采样和卷积参数,而不使用跳跃层连接。

模型功能:该网络参考沙漏和级联金字塔网络而成。正常卷积发生在起始层,当数据压缩到一定程度时,对数据进行采样处理并进行去卷积,与密度较低的体系结构相比,这听起来更有效。

评价参数:以平均平均精度(AP)作为评价参数。

使用的数据集:COCO

讨论的测试结果:通过ResNet-152架构训练的COCO TEST-DEV上的AP为73.7,AP50为91.9。

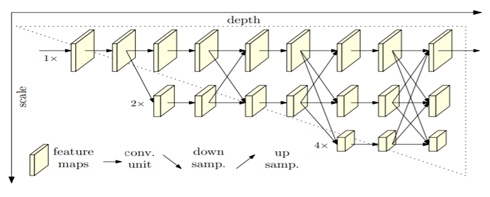

5.用于人体姿态估计的深度高分辨率表示学习算法:KE SUN et。al.,Bin et.等,董等人。艾尔。和京东等。艾尔。表示了一种基于自上而下的方法,以高到低分辨率的网络为基础,分阶段、并行地逐个进行。它不使用中间热图监控。通过MSE损失对热图进行了分析。

模型功能:该网络并行连接高到低分辨率的子网络,以获得更精确的空间热图。整个过程和多分辨率表示都保持了较高的分辨率,有助于通过热图进行图像分割和关键点标注。

评价参数:以平均平均精度(AP)作为评价参数。

使用的数据集:COCO和MP-II

测试结果讨论:采用HRNet-W48架构训练的AP为75.5,AP50为92.5。经HRNet-W48+额外数据架构训练的AP为77.0,AP50为92.7。

多极估计

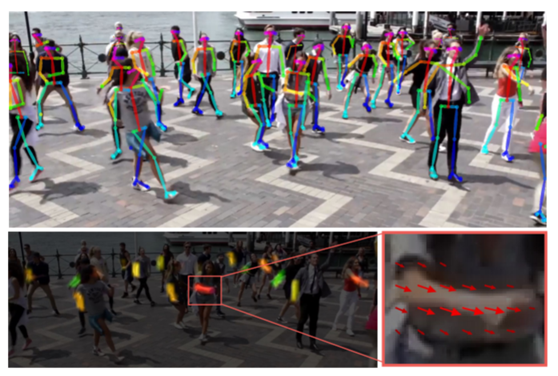

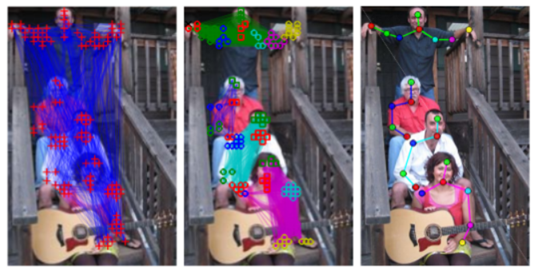

1.OpenPose:基于局部亲和场的实时多人二维位姿估计:哲等。al.,Gines et.等人,Tomas et.等,施恩等人。艾尔。和Yaser et.艾尔。利用局部亲和场进行实时多人二维姿态估计,使网络学习每幅图像上的人体部位。

模型的功能:该模型采用基于亲和力的方法,如图13所示。每个部分都采用了亲和力模型和置信度图的方法。该网络保留了感受场,减少了计算量。为了得到正确的关键点方向,图像的每个像素都应用了部分亲和力的过滤。

评价参数:以正确关键点百分比(PCKh)作为评价参数。

使用的数据集:COCO、MP-II和COCO+FOOT

测试结果讨论:MP-II测试结果头部得分最高,为91.2,踝部得分最低,为61.7。

2.深度切割:多人姿态估计的联合子集划分与标注:Leonid et。al.,Eldar et.al.、思玉等人。等人,Bjoern等人,Mykhaylo等人。等,彼得等人。艾尔。还有伯恩特。艾尔。表示多尺度上的关节姿态估计方法。它能够调整遮挡图像。基于CNN的部分检测器用于身体部分集合的划分和标记形成。

模型的功能:用于身体部位检测器的快速R-CNN方法。采用了建立在VGG模型基础上的密集CNN模型。该公式提出了联合子集划分和标记问题。

评价参数:以正确关键点和零件百分率(PCKh)和(PCp)作为评价参数。

使用的数据集:LSP(单姿势)和We Are Family(WAF-多姿势)

测试结果表明:LSP的位姿估计在PCP尺度上,躯干的位姿估计在AFR-CNN和Dense-CNN上最大,分别为92.9和96.0,前臂的位姿估计最小,分别为64.2和71.7。

3.RMPE:区域多人姿态估计:郝树等。等,舒琴等人。等,余荣等人。al.、Cewu et.艾尔。表示多姿势估计的自上而下方法。对称空间变换网络用于从不合适的包围盒中提取高质量的单人区域。单人姿态估计器用于预测人体姿态骨架的大小调整区域。在重新映射时,采用空间去变形网络来实现人体姿态到实际图像坐标系的映射。为了解决冗馀位姿推导问题,采用了一种参数化位姿非最大值抑制方法。

模型的功能性:该方法使用基于VGG的SSD-512作为人体检测器,因为它对于基于识别的方法是有效的。堆叠沙漏网络也适用于单人姿势估计。对于STN,使用了ResNet-18。基于RESNETâuro“152的快速RCNN用于位姿估计,位姿网络的替换由PyraNet完成。

评价参数:以平均平均精度(AP)作为评价参数。

使用的数据集:MP-II和MSCOCO

测试结果讨论:MP-II的平均准确率为72MAP。当网络使用基于更快的RCNN的ResNet时,观察到的准确率最高,头部为91.3,手腕最低,为76.4。

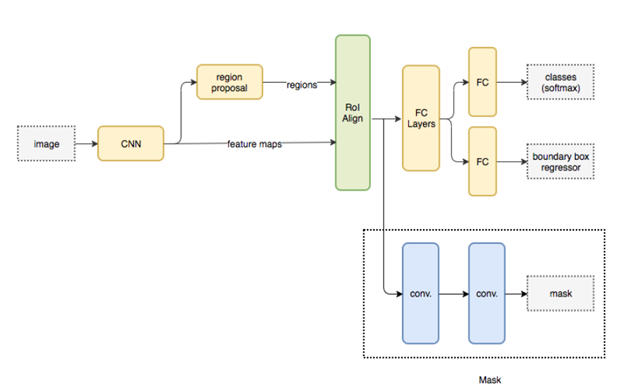

4.屏蔽R-CNN:开明等人。al.、佐治亚等人(George et.)等人,Piotr Dollar et.艾尔。和Ross et.艾尔。表示用于执行语义和实例分段的狮子化体系结构。它是扩展得更快的RCNN模型。在需要数据或特征提取的情况下,将图像大小调整为遮罩大小。

模型的功能:基本架构首先使用CNN从图像中提取特征地图。这也是在目标图像上生成蒙版的一种自上而下的方法。ResNeXt用于对图像进行训练。

评价参数:以正确关键点百分比(PCKh)作为评价参数。

使用的数据集:COCO

讨论的测试结果:ResNeXt-50-FPN用于网络深度特征的结果为36.7AP和59.5AP 50。

原创文章,作者:fendouai,如若转载,请注明出处:https://panchuang.net/2021/06/22/%e5%8d%95%e6%9e%81%e5%92%8c%e5%a4%9a%e6%9e%81%e4%bc%b0%e8%ae%a1%e6%96%87%e7%8c%ae%e7%9a%84%e6%94%b6%e9%9b%86%e4%b8%8e%e6%80%bb%e7%bb%93/