在这个故事中,对SenseTime Research、香港中文大学和北航的Grid R-CNN进行了评论。在本文中:

- 网格R-CNN是为了显式捕捉空间信息而提出的,它具有全卷积结构的位置敏感特性。

- 设计了多点监督公式来编码更多的线索,以减少特定点预测不准确的影响。

- 采用两阶段信息融合策略对相邻网格点的特征图进行融合。网格引导的定位方法很容易扩展到不同的检测框架。

这是一篇2019年CVPR的论文,被引用130多篇。(曾锡豪@Medium)Sik-Ho Tsang

大纲

- Grid R-CNN与CornerNet有很大的不同。

- CornerNet是一种自下而上的方法,不需要定义实例,直接从整个图像生成关键点。角网的关键一步是识别关键点并正确分组。

- 与此不同的是,Grid R-CNN是一种自上而下的两级检测器,它在第一级定义实例。重点研究的是如何准确定位网格点。

2.1.网格引导定位

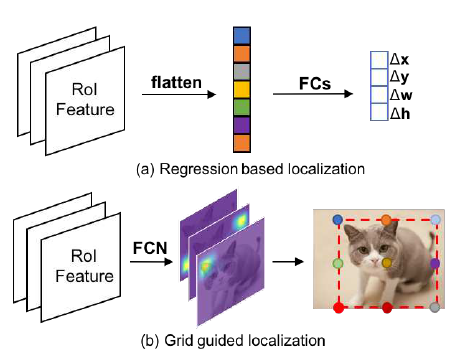

- 大多数以前的方法使用几个完全连通的层作为回归变量来预测边界框,如第一个图的(A)所示。

- 在网格R-CNN中,设计了一种N×N网格形式的目标点对齐在对象的边界框中,以便可以应用任何FCN体系结构,如第一图(B)所示。

- 每个方案的特征由RoIAlign提取,用于Mask R-CNN,操作空间大小固定为14×14,然后是8个3×3膨胀的(大感受野)卷积层。

- 之后,采用两个2×组反褶积层位,分辨率达到56×56。

- 网格预测分支输出56×56分辨率的N×N个热图,并对每个热图应用像素方向的Sigmoid函数以获得概率图。

- 每个热图都有相应的监督图,其中十字形的5个像素被标记为目标网格点的正位置。

- 利用二元交叉熵损失进行优化。

2.1.1。从热图到原始图像的网格点映射

- 在推理过程中,在每个热图上选择置信度最高的像素,并计算原始图像上的对应位置作为网格点。

- 形式上,热图中的点(Hx,Hy)将通过以下公式映射到原始图像中的点(Ix,Iy):

- 其中(px,Py)是方案在输入图像中的左上角位置,wp和hp是方案的宽度和高度,wo和ho是输出热图的宽度和高度。

2.1.2。根据网格点确定边界框

- 然后利用预测的网格点确定目标方框的四个边界。

- 具体地说,四个边界坐标被表示为B=(xl,Yu,xr,yb),分别表示左边缘、上边缘、右边缘和下边缘。

- 设gj用坐标(xj,yj)和预测概率pj表示第j个网格点。

- Ei被定义为位于第i条边的网格点的索引集合。

- 如果Gj位于边界框的第i条边。我们有以下公式来计算具有g集合的B:

- 以上界Yu为例,它是三个上网格点y轴坐标的概率加权平均。

2.2.栅格点要素融合

- 网格点具有内在的空间相关性,它们的位置可以相互标定,以减少整体偏差。

- 为了区分不同点的特征图,使用N×N组滤波器分别提取不同点的特征(从最后一个特征图)。

- 对其对应的网格点进行中间监督。

- 因此,每个特征地图具有与某个网格点的指定关系,并且对应于第i个点的特征地图被表示为Fi。

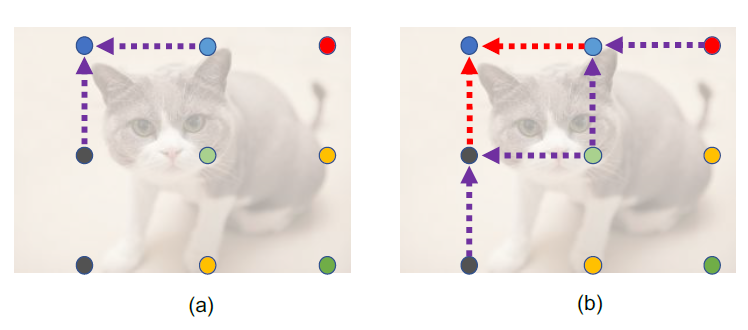

- (A)一阶:对于每个网格点,L1距离为1(单位网格长度)的点将有助于融合,称为源点。第i个网格点的源点集w.r.t被定义为Si。

- 对于Si中的第j个源点,Fj将由三个连续的5×5卷积层处理以用于信息传送,并且该过程被表示为函数Tj→i。

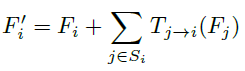

- 然后将所有源点的处理后的特征与Fi进行融合,得到融合特征图F‘i。

- 如上所示,融合使用简单的求和运算。

- (B)二阶:基于每个网格点的F‘i,然后利用与第一阶融合不共享参数的新的对流层T+j→i执行第二阶融合。

- 利用二阶融合特征图F‘’i输出最终的热图进行网格点位置预测。

- 二阶融合实现了2(L1距离)范围内的信息传输。

- 以3×3网格中的左上角网格点为例(如上图(B)所示),它综合了其他5个网格点的信息,以便进行可靠的校准。

2.3.扩展区域映射

- 输出热图自然对应于原始图像中输入方案的空间区域。

- 然而,区域建议可能不会覆盖整个对象,这意味着一些地面真实网格点可能位于建议区域之外,无法在监督地图上标注或在推理过程中预测。

- 如上所示,方案(小白框)比地面真值边界框小,输出热图无法覆盖9个栅格点中的7个。

- 一个自然的想法是扩大提案范围。该方法可以保证大部分网格点都包含在建议区内,但也会引入背景甚至其他物体的冗余特征。

- 作者通过一种扩展的区域映射方法修改了输出热图与原始图像中区域的关系。

- 具体地说,当获得提案时,在不扩大提案面积的情况下,仍然从特征地图上的相同区域提取ROI特征。

- 同时将输出热图的表示区域重新定义为图像中两倍大的相应区域,以便在大多数情况下覆盖所有网格点,如上图所示(虚线框)。

- 扩展区域映射使用新映射:

- (简而言之,在考虑功能地图时,仅考虑原始ROI中的功能地图。在考虑网格点时,应使用扩展区域映射,即使用上述映射方程。)

3.烧蚀研究

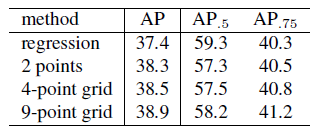

3.1.多点监管

- 两点实验采用地面真实盒的左上角和右下角监督。

- 在4点网格中,我们增加了对另外两个角点网格点的监督。

- 9点网格是一种典型的3×3网格公式。

3.2.栅格点要素融合

- 从用于网格点位置预测的一阶特征融合阶段得到的特征图,其增益与双向融合的增益相同,为0.3%AP。

- 二阶融合使AP进一步提高了0.4%,比未融合基线提高了0.7%。

- 特别是AP0.75比AP0.5的改进更为显著,说明特征融合机制有助于提高包围盒的定位精度。

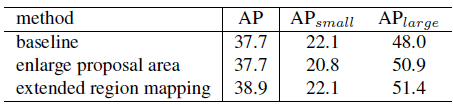

3.3。扩展区域映射

- 直接扩大ROI特征提取的建议框区域有助于覆盖更多的大目标网格点,但也带来了小目标的冗余信息。

- 因此,APLarge有所增加,而APSmall有所下降。

- 扩展区域映射策略提高了AP Large的性能,同时对AP Small没有负面影响,使AP的性能提高了1.2%。

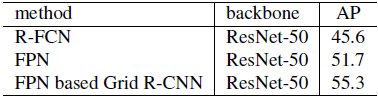

4.SOTA比较

4.1.帕斯科挥发性有机化合物

- 网格R-CNN较FPN和R-FCN分别显著提高AP 3.6%和9.7%。

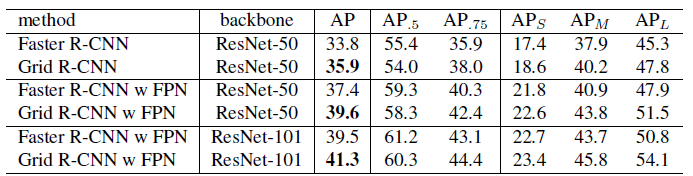

4.2.可可迷你

- 与更快的R-CNN框架相比,使用ResNet-50骨干网,Grid R-CNN使AP比基线提高了2.1%。

- 网格R-CNN使中型和大型对象的性能显著提高了约3个点。

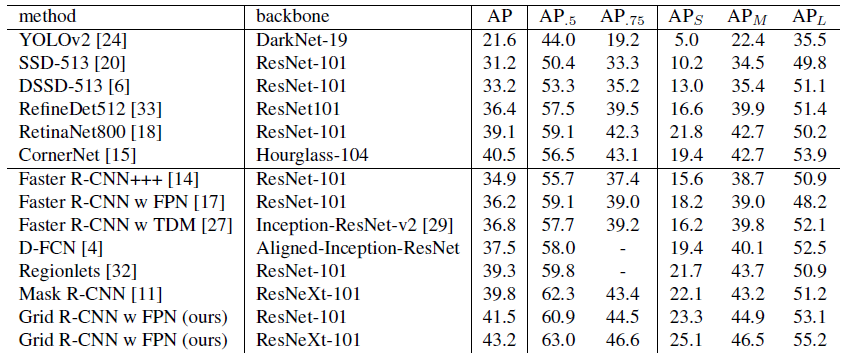

4.3.COCO测试开发

- 采用RESNET-101和ResNeXt-101,顶部构建FPN。

- 与其他最先进的检测器相比,Grid R-CNN实现了非常好胜的性能。

- 它在不使用任何额外注释的情况下,大大超过了Mask R-CNN。

- Grid R-CNN的表现也优于YOLOv2,SSD,DSSD,RefineDet,RetinaNet,CornerNet。

5.进一步分析

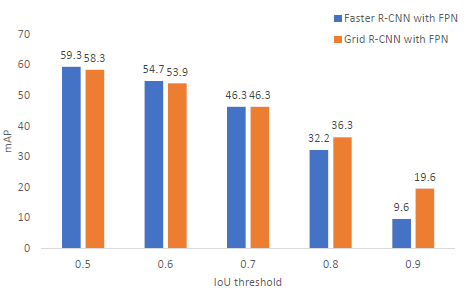

5.1.不同欠条标准的准确性

- 网格R-CNN在较高的IOU阈值(大于0.7)时表现优于回归。AP0.8和AP0.9比基线分别提高了4.1%和10%。

- 另外,AP0.5的计算结果表明,网格分支对分类分支的性能影响不大。

5.2.在不同类别中有不同程度的改善

- 涨幅最大的类别通常具有矩形或条形形状(例如键盘、笔记本电脑、叉子、火车和冰箱),而下跌或涨幅最小的类别通常具有没有结构边缘的圆形(例如运动球、飞盘、碗、钟表和杯子)。

- 这种现象是合理的,因为网格点是以矩形分布的。

5.3.定性结果比较

- 如图所示,网格R-CNN(第1排和第3排)与广泛使用的速度更快的R-CNN(第2排和第4排)相比,在精确定位方面表现突出。

参考文献

[2019 CVPR][Grid R-CNN]Grid R-CNNGrid R-CNN

目标检测

2014:[OverFeat][R-CNN]2015:[FAST R-CNN][FASTER R-CNN][MR-CNN&S-CNN][DeepID-NET]2016:[OHEM][Craft][R-FCN][ION][MultiPathNet][Hikvision][GBD-NET/GBD-v1&GBD-v2][SSD][YOLOv1]2017:[NOC][G-RMI][TDM][DSSD[FPN][RetinaNet][DCN/DCNv1][Light-Head R-CNN][DSOD][CoupleNet]2018:[YOLOv3][Cascade R-CNN][MegDet][StairNet][RefineDet][CornerNet]2019年:[DCNv2][Reink ImageNet预培训][GRF-DSOD&GRF-SSD][Centernet][GridOverFeat R-CNN Fast R-CNN Faster R-CNN MR-CNN & S-CNN DeepID-Net OHEM CRAFT R-FCN ION MultiPathNet Hikvision GBD-Net / GBD-v1 & GBD-v2 SSD YOLOv1 NoC G-RMI TDM DSSD YOLOv2 / YOLO9000 FPN RetinaNet DCN / DCNv1 Light-Head R-CNN DSOD CoupleNet YOLOv3 Cascade R-CNN MegDet StairNet RefineDet CornerNet DCNv2 Rethinking ImageNet Pre-training GRF-DSOD & GRF-SSD CenterNet Grid R-CNN

我以前的其他论文阅读

原创文章,作者:fendouai,如若转载,请注明出处:https://panchuang.net/2021/07/14/%e5%9b%9e%e9%a1%be%e2%80%8a-%e2%80%8a%e7%bd%91%e6%a0%bcr-cnn%e7%9b%ae%e6%a0%87%e6%a3%80%e6%b5%8b/