半监督学习将再度兴起!谷歌祭出大杀器:无监督数据增强

精品文章,第一时间送达

作者:Qizhe Xie等

编译:闫娜、李翔宇

转载自:图灵Topia(ID:turingtopia),未经允许不得二次转载

近日,谷歌AI发布了一篇博文,博文指出可以对无标注数据执行数据增强,从而显著提高了半监督学习(SSL)的性能,因此研究人员相信”半监督学习将再度兴起!“

以下是具体内容:

很大程度上,影响深度学习成功的关键因素有:算法的进步、并行处理硬件(GPU / TPU)以及大规模标注数据集的可用性(如ImageNet)。

然而,当标注数据稀缺时,很难通过训练使神经网络表现良好。这种情况下,研究人员可以应用数据增强技术,例如:通过转述一个句子或旋转一个图像,可以有效加的训练数据量。

近来,在用于自然语言处理(NLP)、视觉和语音等领域的数据增强方法上,已经取得了重大进展。遗憾的是,数据增强通常仅限于监督学习,在这种学习中,标签需要从原始示例迁移到扩展示例。

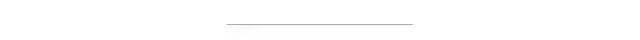

基于文本(顶部)或基于图像(底部)的训练数据的增强操作示例。

在近来的工作中《用于一致性训练的无监督数据增强(UDA)》一文中,我们发现可以对无标注数据执行数据增强,从而显著提高半监督学习(SSL)的性能。

基于此,我们相信SSL会再度兴起,理由如下:

(1)SSL可以匹配甚至优于使用更多标记数据的纯监督学习。

(2)SSL可用于文本和视觉的跨领域工作。

(3)SSL可结合迁移学习,例如,在BERT的微调。

GitHub传送门:

https://github.com/google-research/uda

无监督数据增强

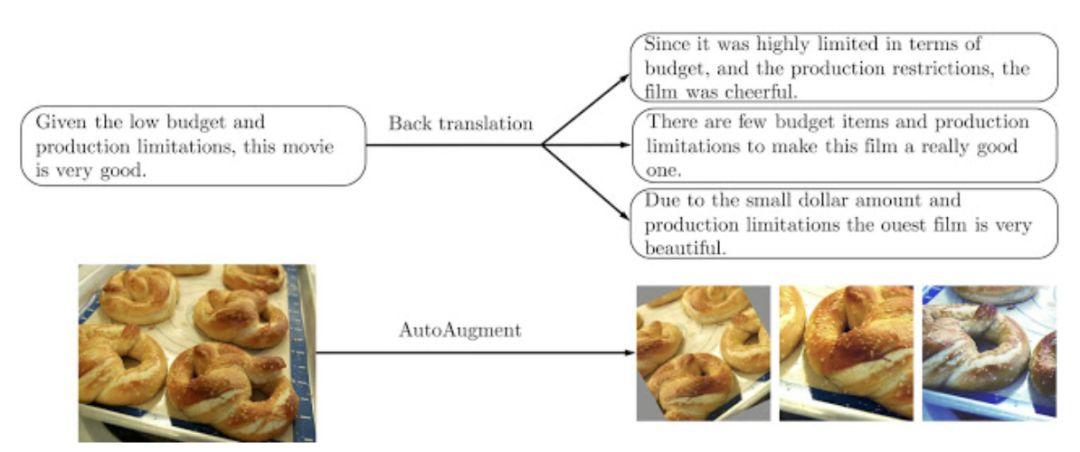

无监督数据增强(UDA)同时使用标记数据和未标记数据。为了使用标记数据,UDA使用监督学习的标准方法来计算损失函数以此来训练模型,如下图左侧所示。

对于未标注的数据,在一致性训练中,应用于强制未标注的示例和增强未标注的示例的预测相似。如图右侧所示。

在这里,将相同的模型应用于未标注的示例和增强的对应示例,以生成两个预测模型,从中计算一致性损失(即两个预测分布之间的距离)。然后,UDA通过联合优化标注数据的监督损失和未标注数据的无监督一致性损失来计算最终的损失。

关于无监督数据增强的概述

左: 使用标注数据计算标准监督损失。右:使用未标注的数据,计算示例与其增强版本之间的一致性损失。

通过最小化一致性损失,UDA可将标注信息从已标注示例传播到未标注示例。直观地说,可以将UDA看作一个隐式迭代过程。

首先,该模型通过少量标记示例正确预测一些未标注的示例,通过一致性损失将标注信息传播到到增强的对应项中。

随着时间的推移,将会正确预测更多未标注的示例,这反映了模型被普遍改进。其他各类噪音也经过了一致性训练的测试(如高斯噪声、对抗性噪声等),然而,我们发现数据增强比这些表现都好,从而在语言到视觉的各种任务上都达到了最先进的水平。UDA根据任务不同应用(包括反向翻译、自动增强和TF-IDF单词替换)等不同的增强方法,

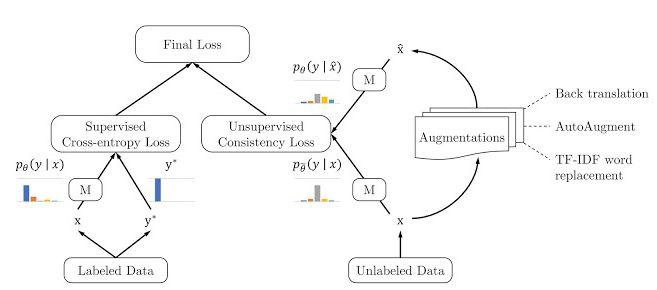

NLP和计算机视觉的基准

在IMDb的情绪分析任务中,只用20个标记示例,UDA通过50000个未标记的示例,实现了4.20的错误率。在之前的模型训练中,UDA使用25,000个标记的示例,错误率为4.32。上述结果表明,在低数据环境下,UDA更有效。大数据体制下,UDA使用完整的训练集,提供了巨大的收益。

IMDb的基准是一种情绪分析任务。在不同培训规模的监督学习中,UDA最先进。

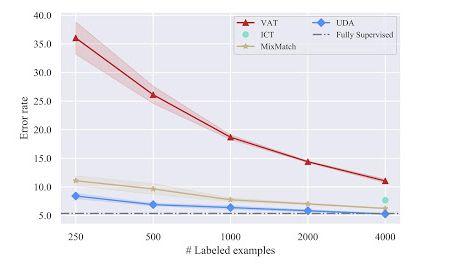

在CIFAR-10半监督学习的基准上,UDA的性能比现有的SSL方法(如VAT、ICT和MixMatch)都要好得多。

使用4k的示例,UDA的错误率为5.27,与使用50k示例的全监督模型的性能相匹配。此外,由于采用了更先进的体系结构PyramidNet+ShakeDrop, UDA实现了2.7的最新错误率,与之前最好的半监督结果的错误率相比降低了45%以上。

在SVHN上,UDA使用250个标注的样本,错误率是2.85,与经过~70k标注样本训练的全监督模型的性能相匹配。

基于CIFAR-10的SSL基准测试是一个图像分类任务。UDA超越了所有使用Wide-ResNet-28-2结构的半监督学习方法,在4000个示例中,UDA的性能与50,000个示例的完全监督设置相匹配。

在ImageNet上,使用10%标注的示例时,UDA将top-1的准确率从55.1%提高到68.7%。在高数据状态下,使用完全标注集和额外130万个未标注的示例,UDA将top-1的精度从78.3%提高到79.0%。

参考链接:

https://ai.googleblog.com/2019/07/advancing-semi-supervised-learning-with.html

你也许还想看:

● 一文彻底搞懂BP算法:原理推导+数据演示+项目实战(上篇)

● TensorFlow + Keras 实战 YOLO v3 目标检测图文并茂教程(文末有惊喜)

● 入门 | Tensorflow实战讲解神经网络搭建详细过程

欢迎扫码关注:

原创文章,作者:fendouai,如若转载,请注明出处:https://panchuang.net/2019/07/24/1cde439bcf/