作者 | Aleksandr Movchan

编译 | VK

来源 | Medium

问题

-

样本效率:深度学习的样本效率很差。例如,为了识别数字,我们通常每个数字需要6000个样本。 -

可移植性差。我们不会从以前的经验或学到的知识中学习。

元学习

-

循环模型 -

元优化 -

度量学习

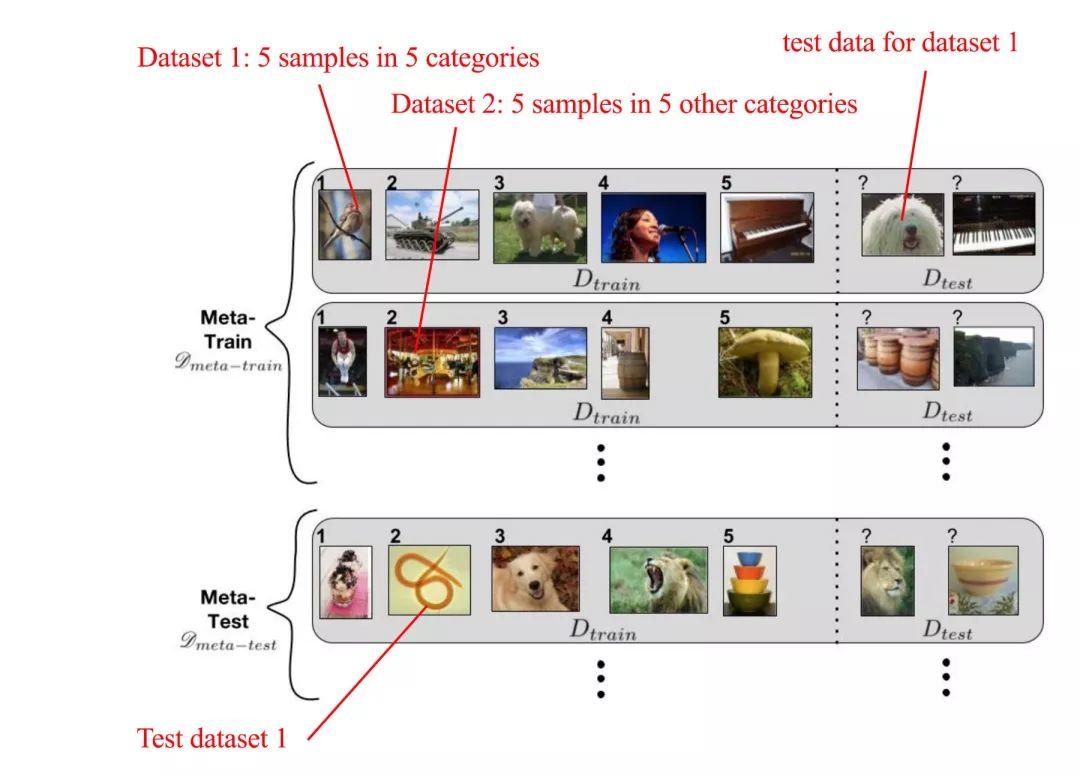

少量学习(Few-Shot)

如果我们更聪明地收集任务,我们会学得更好。

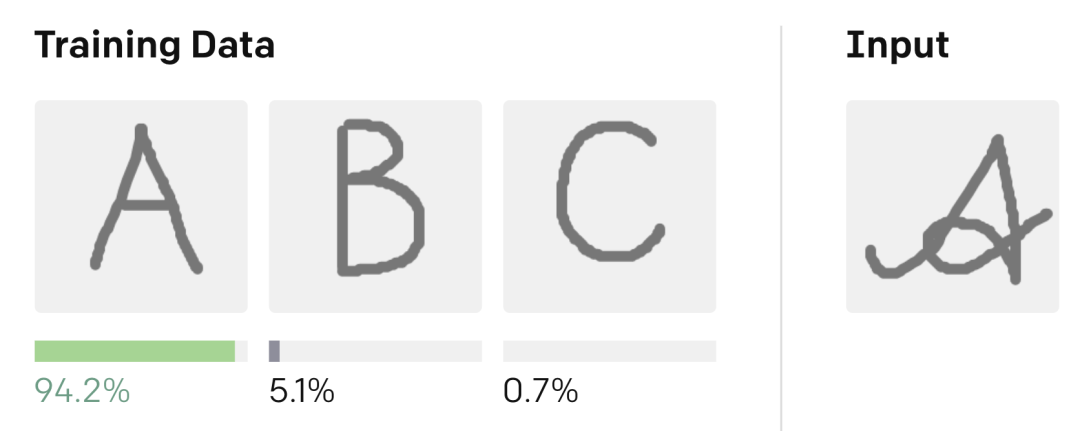

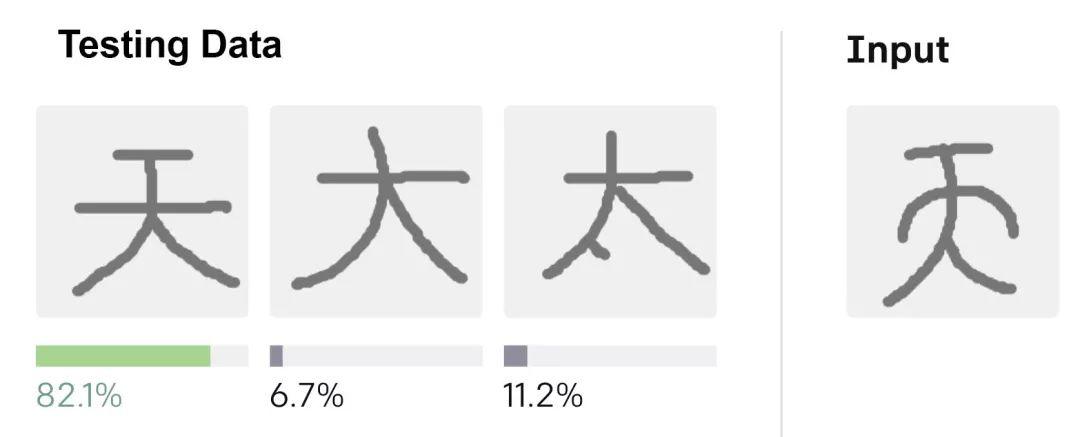

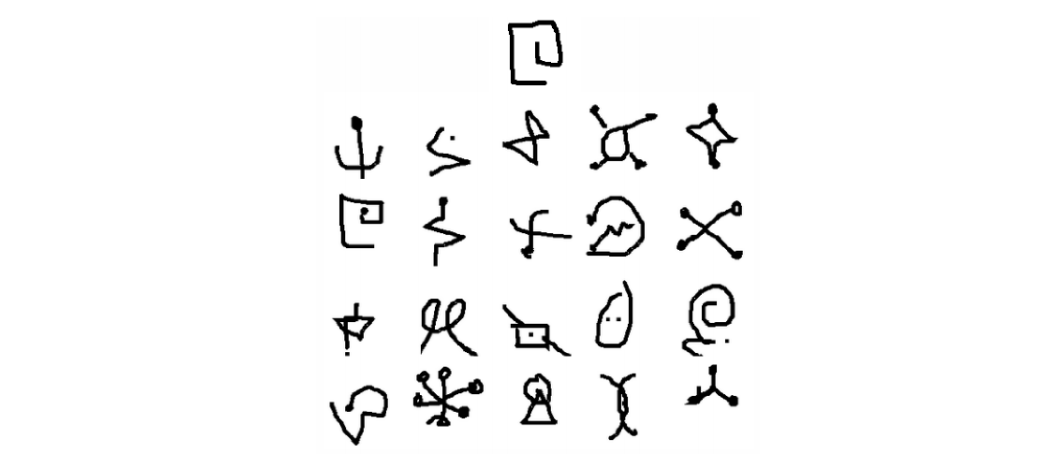

Omniglot

在我们讨论细节之前。让我们介绍Omniglot。它是一个流行的Few-Shot学习数据集。以下是来自Omniglot的20幅代表不同的20个类的画。

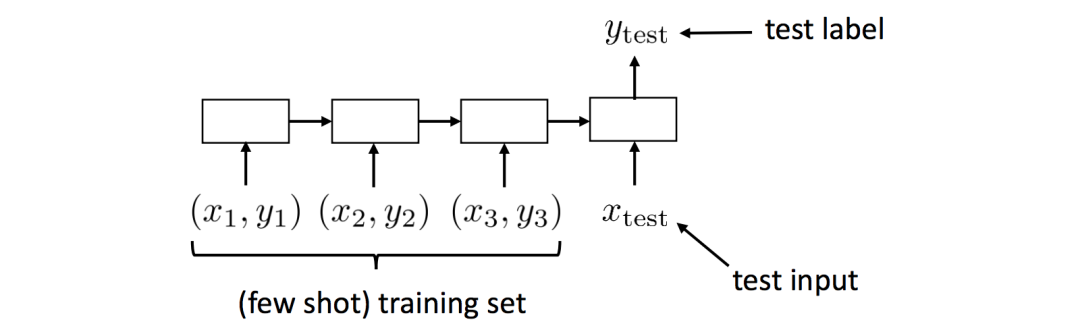

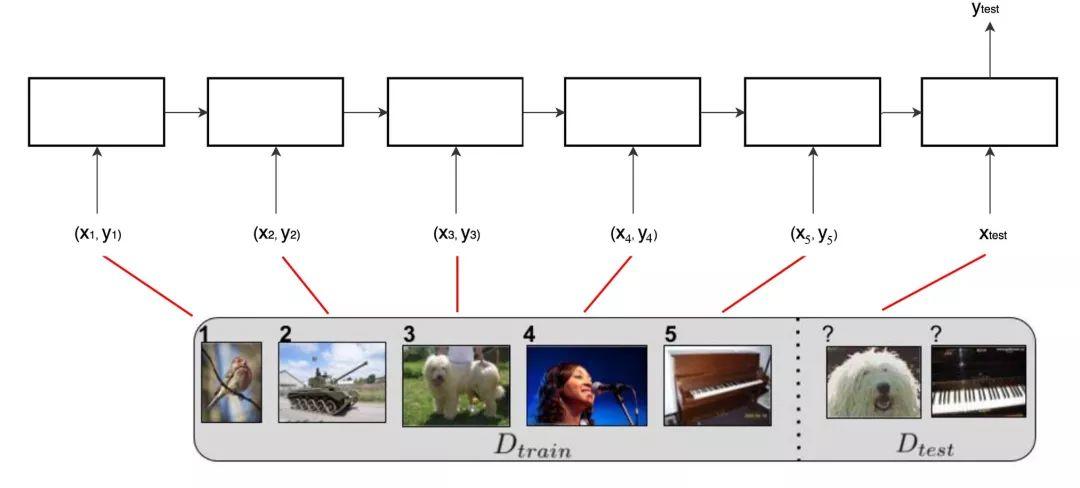

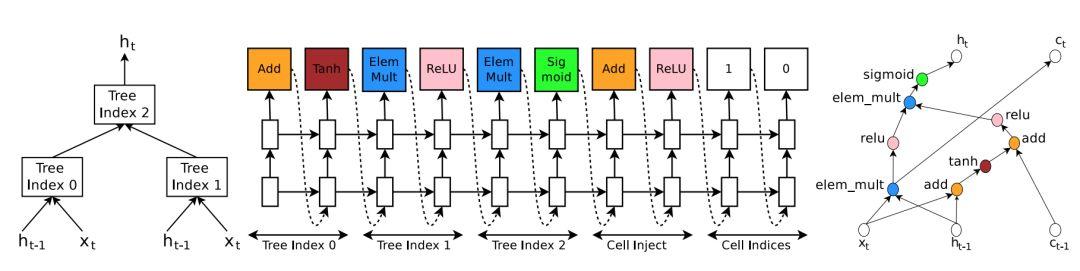

循环模型

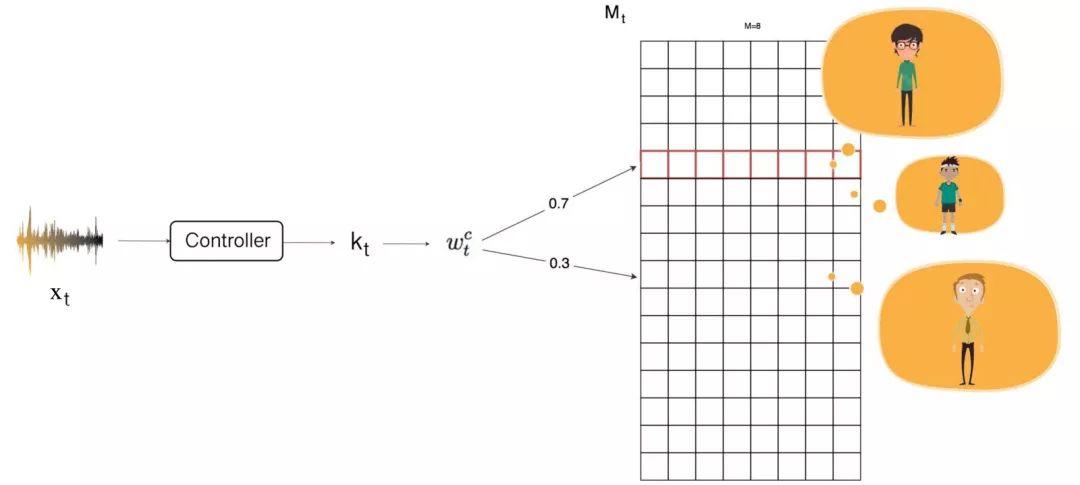

训练记忆增强神经网络

如果我们能从经验中学习,我们会学得更好。

学习优化器

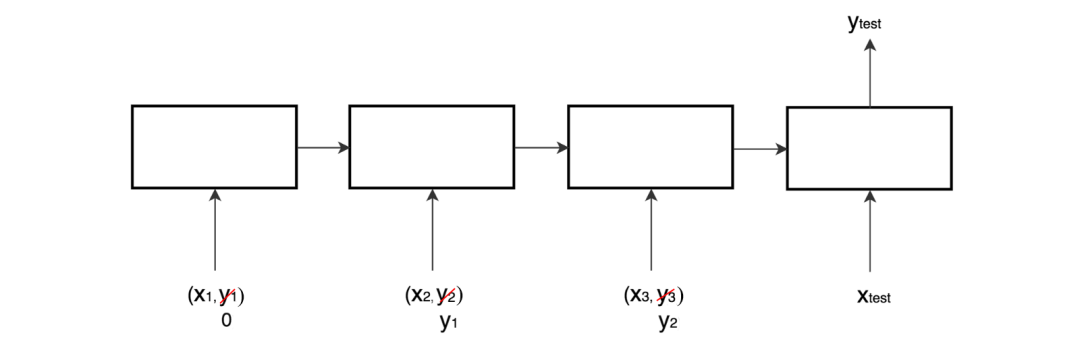

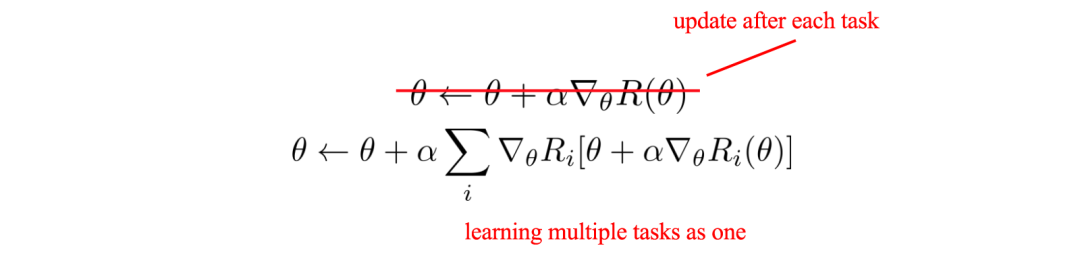

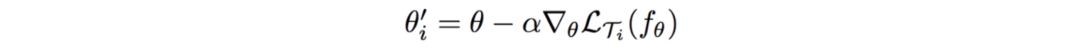

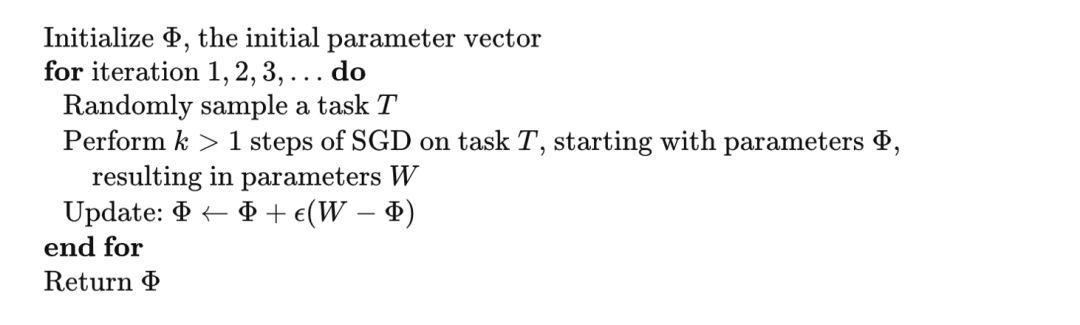

模型无关元学习(MAML)利用上面的概念来更新模型。它是简单的,它几乎是相同的,我们的传统DL梯度下降与增加一行代码如下。在这里,我们不会在每个任务之后立即更新模型参数。相反,我们一直等到一批任务完成

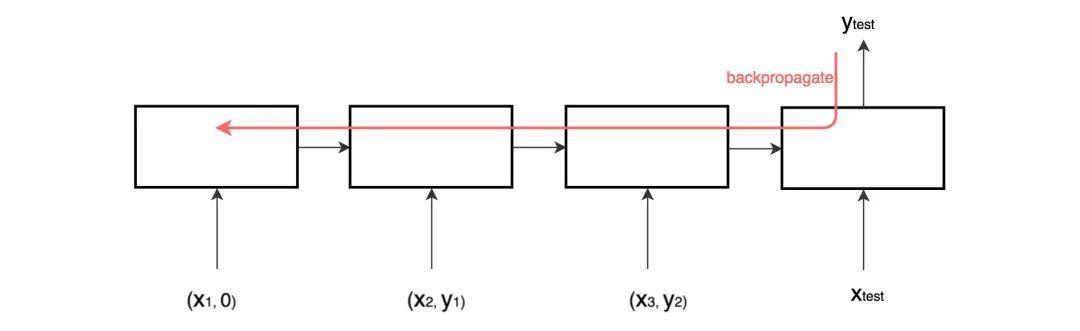

对于每个任务,我们使用反向传播来计算建议的模型。

然后合并训练任务的损耗,并将损耗进行反向传播,进行下一次模型更新:

从概念上讲,我们正在寻找一个最小化任务损失的模型。

如果我们优化得更好,我们就学得更好。

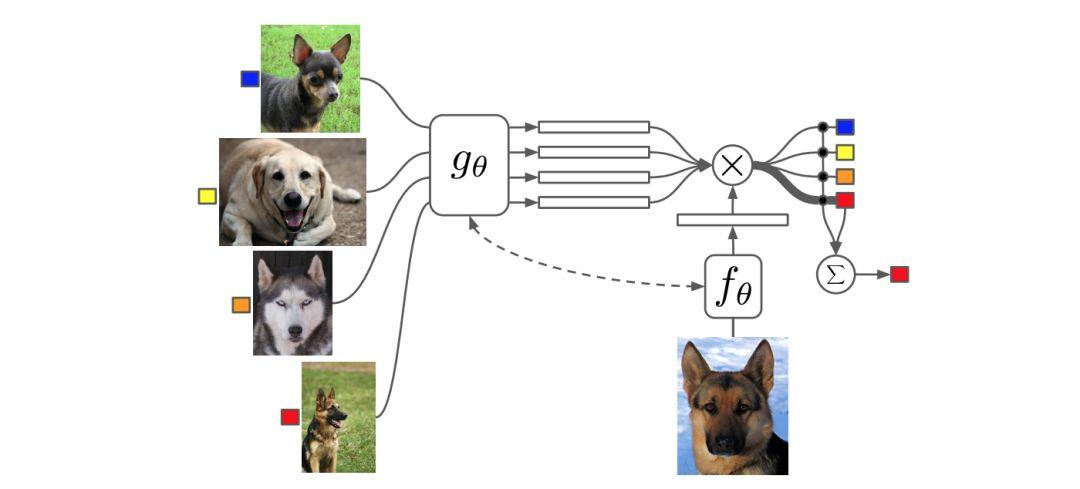

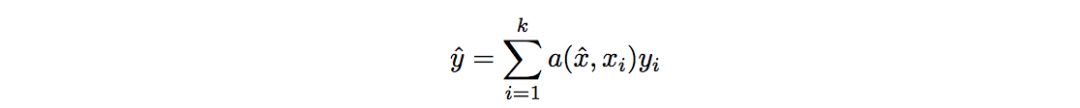

度量学习

还有一种方法叫做Matching网络,它与Siamese神经网络非常相似。

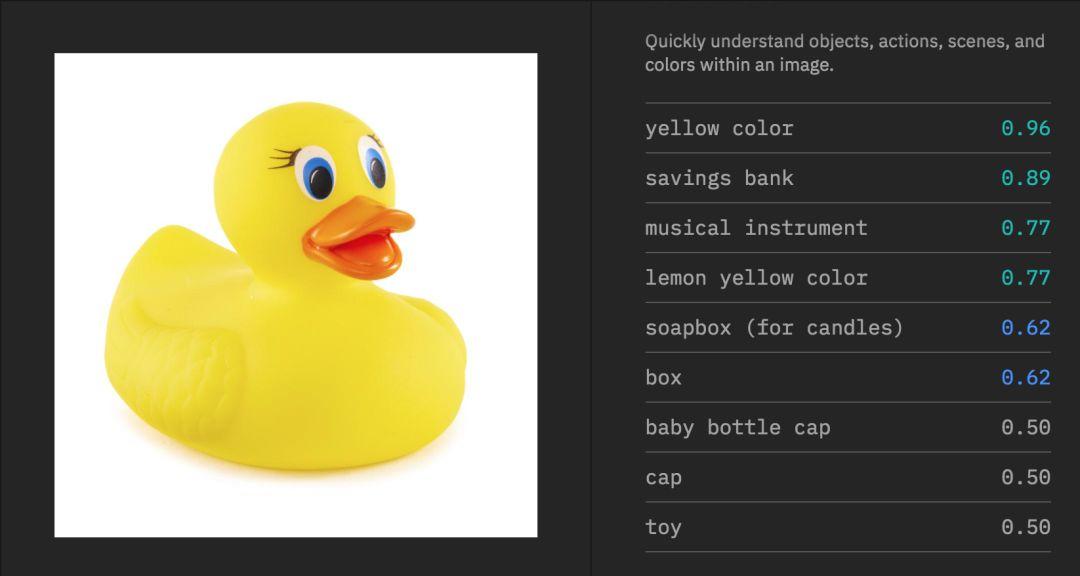

如果我们知道如何更好地表示数据,我们就学得更好。

其他方法

想法

-

收集更好的信息来学习。 -

更好地从过去的经验中学习。 -

更好地知道如何表示信息。 -

如何更好地优化模型。 -

探索更好的方法。 -

将联系变得更好。 -

将泛化变得更好。

长按扫码,关注我们

长按扫码,关注我们你与未来只差一个

磐创AI

点击阅读原文,获得更多精彩内容

原创文章,作者:磐石,如若转载,请注明出处:https://panchuang.net/2020/02/11/69728827cf/