几周前,Open AI推出了两种计算机视觉模型,它们可以成为基于视觉的技术的未来-Dall-E和CLIP。DALL-E具有从图像生成文本的能力,而CLIP通过将图像分类转变为文本相似性问题来对非常广泛的图像进行分类。

开放人工智能旨在通过CLIP解决什么问题?

尽管在接下来的几年里,我们在计算机视觉领域看到了过多的改进,但它们都有一些缺点-

OpenAI旨在用CLIP解决这些数据集大、现实性能差的问题。事实证明,CLIP不仅提供了最先进的图像分类结果,而且还提供了其他视觉任务,如对象分类、视频中的动作识别和OCR。这表明,像CLIP这样的单一算法可以处理各种任务和数据集,而不需要构建巨大的数据集,但是计算成本很高。

对比学习原理

对比学习是为ML模型制定寻找相似和不相似事物的任务的一种方法。使用这种方法,人们可以训练机器学习模型来区分相似和不相似的图像。

对比学习对自我监督学习技术的兴趣激增,特别是在计算机视觉方面,有Simclr和MOCO这样的论文。Simclr Moco

裁剪算法概述

OpenAI的团队融合了许多最先进的工作方法,如零镜头传输、自然语言监控和多模式学习。让我们从高层次概述剪辑的工作方式开始

它从一批在互联网上很容易找到的文本和图像对开始。这些文本和图像分别被传递到文本和图像编码器,并且进行相似性搜索,其中图像被映射到来自整个批次的对应文本。这种图像和文本的对齐是对比性的预训练方法。在医学成像领域的ConVIRT论文中也实施了类似的方法。ConVIRT

一旦图像和文本已经匹配,就可以执行零镜头预测。这里发生的情况是,数据集中的所有类都是以特定格式排列的,比如“{classname}的照片”,并将其送入编码器。与对比预训练类似,图像被传递给编码器,并且编码器执行相似性搜索以确定哪些文本与来自整批图像的图像匹配,即,文本编码器将包含一批“{狗}的照片”、“{汽车}的照片”等,并且剪辑将估计与给定图像的最佳配对。例如,我们可以看到鳄梨调味酱在101个班级中排名第一,电视在397个班级中排名第一。

我们已经看到,像这些(GPT-3)这样的零激发方法在计算上是昂贵的。Clip利用了几种不同的方法来实现这一点。我们已经看到的第一种方法是对比预训练方法,它大大减少了计算量。其次,它使用了视觉转换器,进一步提高了比ResNet等标准视觉模型更高的效率。

这种零镜头学习方法加上自然语言监督是CLIP与其他视觉模型的不同之处。通过训练在互联网上容易访问的各种数据,并且不直接对基准进行优化,CLIP具有更广泛的通用性和代表性。

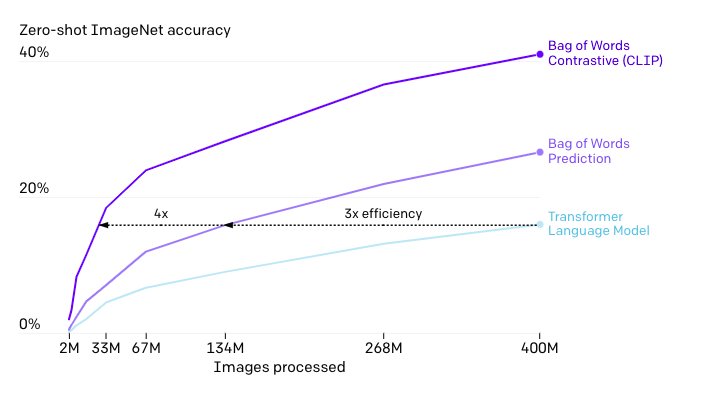

在上图中我们可以看到,与400m相比,该剪辑仅在33m的参数下就达到了语言模型的准确性。CLIP的效率提高了12倍!!由于采用了这种方法,CLIP可以很容易地应用于几乎任何视觉分类任务,并且取得了很好的性能。

现在你可以看到OpenAI的团队已经解决了当前视觉模型的很多问题。CLIP通过向已经公开的文本-图像对学习,减少了SOTA计算机视觉任务所需的劳动密集型大数据集,不仅如此,它还减少了关注有限数量的视觉概念的需要。

您知道ImageNet数据集需要25,000名工作人员为22,000个对象类别的1,400万个图像添加注释吗?那可是一大堆工作啊!

想象一下在您选择的特定数据集上使用预先训练的ImageNet模型。这将需要从头开始构建一个数据集并微调您的模型。但是,Clip所需要的只是将任务的视觉概念的名称传递到文本编码器,它将输出视觉表示的线性分类器。

需要注意的一点是,该剪辑可以与SOTA视觉模型在像ImageNet这样的数据集上的性能相匹配。但是OpenAI也进行了测试,在剪辑的特征上添加线性分类器可以将其准确率提高10%,但是它并不能很好地推广到ImageNet的其他变体上。

夹子-业内最好的?

目前,CLIPS有很多局限性。要提高CLIP的任务学习和迁移能力,还需要做大量的工作。虽然到目前为止,可伸缩性已经稳步提高了性能,但要使零镜头剪辑达到整体最先进的性能,还需要大量的计算。这对于使用当前硬件进行训练是不可行的。

与特定于任务的模型相比,CLIP在几种类型的分类问题上表现出较差的性能,如区分汽车、花卉种类等。另一个限制是CLIP对真正不分布的数据的泛化能力仍然很差。以MNIST为例,Logistic回归的简单基准线优于零偏移。CLIP希望通过在一个大型且多样化的数据集上进行训练,所有数据都将有效地分布,但正如MNIST所展示的那样,这很容易被违反。

正如我们已经看到的,CLIP可以灵活地为各种数据集生成零镜头分类器,但仍然局限于给定的零镜头分类器中的那些概念。我们已经看到了一种类似于图像字幕的方法,与ZS剪辑相比,它可以生成新颖的输出。

结论

CLIP引入了一种非常有趣和灵活的方法来解决计算机视觉问题。它不仅可以克服当今许多视觉模型和方法所面临的问题,而且还能一帆风顺地做到这一点。它能够解决撞击几乎任何视力问题,还能产生令人惊叹的效果,这可不是一个小壮举。OpenAI已经发布了研究论文和代码。paper code

原创文章,作者:fendouai,如若转载,请注明出处:https://panchuang.net/2021/06/20/%e8%ae%a1%e7%ae%97%e6%9c%ba%e8%a7%86%e8%a7%89%e2%80%8a-%e2%80%8a%e5%bc%80%e6%94%beai%e5%af%b9%e6%af%94%e8%af%ad%e8%a8%80%e5%9b%be%e5%83%8f%e9%a2%84%e8%ae%ad%e7%bb%83clip%e7%9a%84%e6%9c%aa%e6%9d%a5/