一文彻底搞懂BP算法:原理推导+数据演示+项目实战(上篇)

本文是全系列中第21 / 23篇:TensorFlow 从入门到精通

- Tensorflow 介绍和安装

- 【干货】史上最全的Tensorflow学习资源汇总

- 文末福利|一文上手TensorFlow2.0(一)

- TensorFlow 卷积神经网络手写数字识别数据集介绍

- 特征工程

- 一文上手最新TensorFlow2.0系列(二)

- 深度学习之激活函数

- Tensorflow实现MNIST手写数字识别

- 一文上手Tensorflow2.0之tf.keras|三

- 卷积神经网络概述

- 损失函数综述

- 一文上手Tensorflow2.0(四)

- TensorFlow 一步一步实现卷积神经网络

- Tensorboard 详解(上篇)

- 深度学习发展史

- Tensorflow从入门到精通之——Tensorflow基本操作

- Tensorboard详解(下篇)

- 卷积的发展历程,原理和基于 TensorFlow 的实现

- 五大经典卷积神经网络介绍:LeNet / AlexNet / GoogLeNet / VGGNet/ ResNet

- TensorFlow 多GPU使用详解

- 一文彻底搞懂BP算法:原理推导+数据演示+项目实战(上篇)

- TensorFlow 实战卷积神经网络之 LeNet

- 深度学习之视频人脸识别系列二:人脸检测与对齐

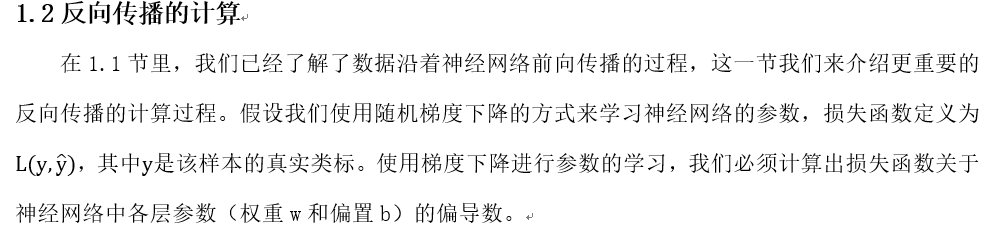

反向传播算法(Backpropagation Algorithm,简称BP算法)是深度学习的重要思想基础,对于初学者来说也是必须要掌握的基础知识!本文希望以一个清晰的脉络和详细的说明,来让读者彻底明白BP算法的原理和计算过程。

全文分为上下两篇,上篇主要介绍BP算法的原理(即公式的推导),介绍完原理之后,我们会将一些具体的数据带入一个简单的三层神经网络中,去完整的体验一遍BP算法的计算过程;下篇是一个项目实战,我们将带着读者一起亲手实现一个BP神经网络(不适用任何第三方的深度学习框架)来解决一个具体的问题。

读者在学习的过程中,有任何的疑问,欢迎加入我们的交流群(扫描文章最后的二维码即可加入),和大家一起讨论!

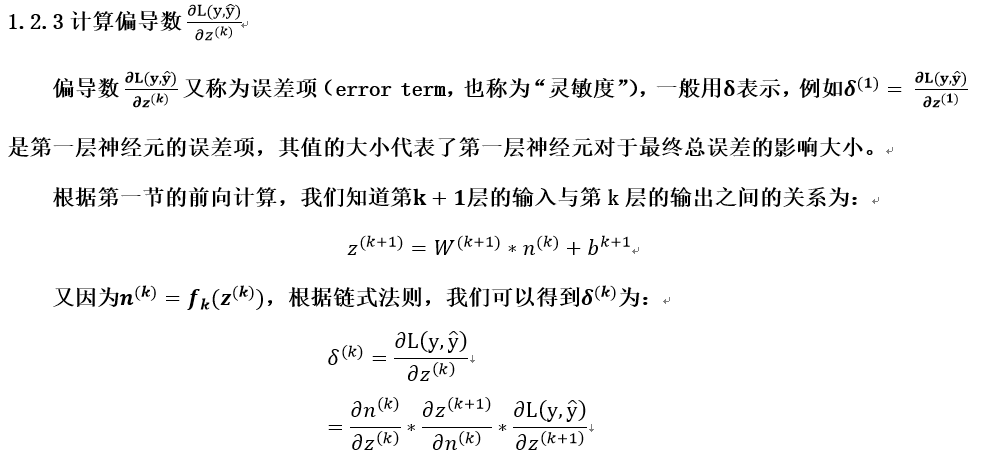

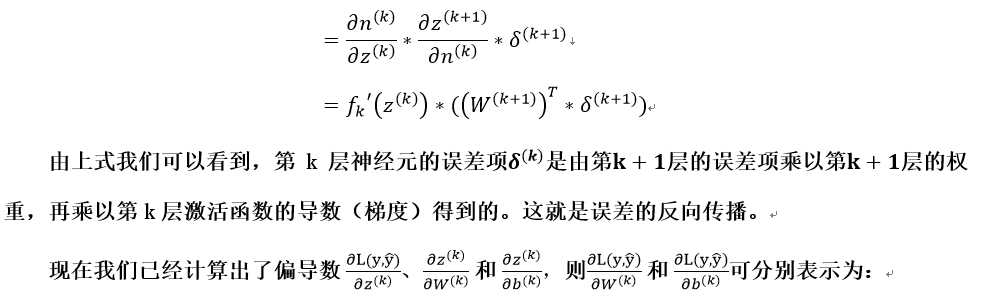

1.BP算法的推导

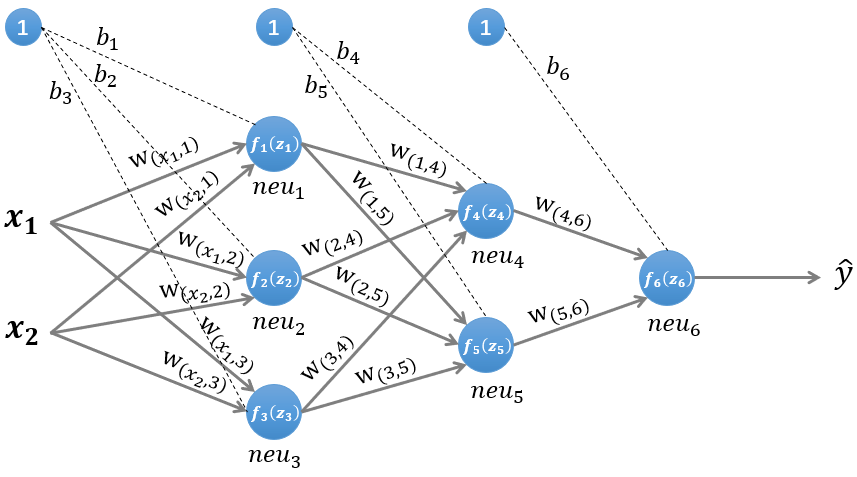

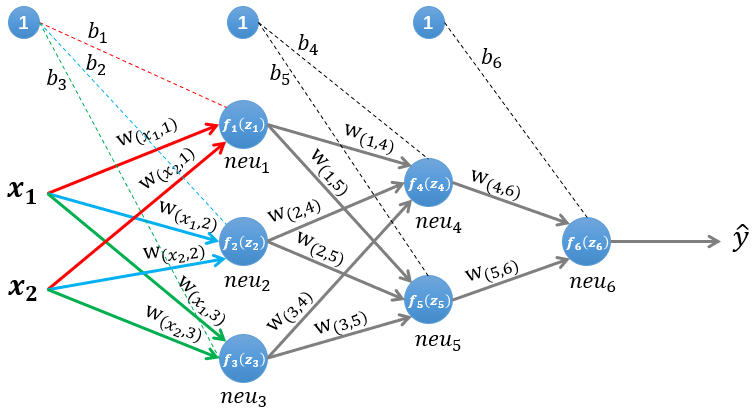

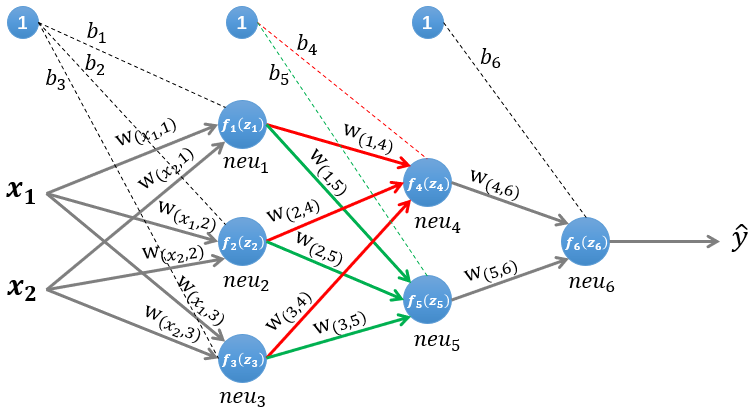

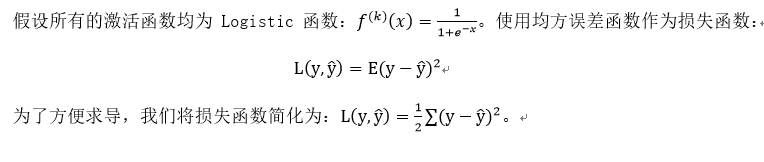

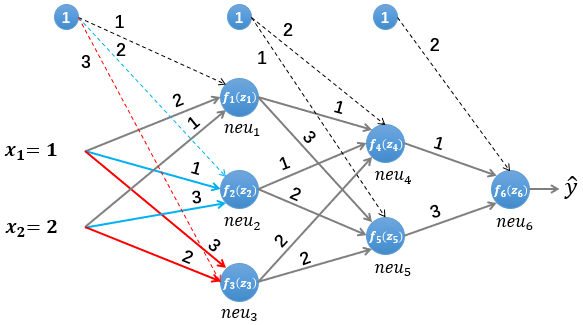

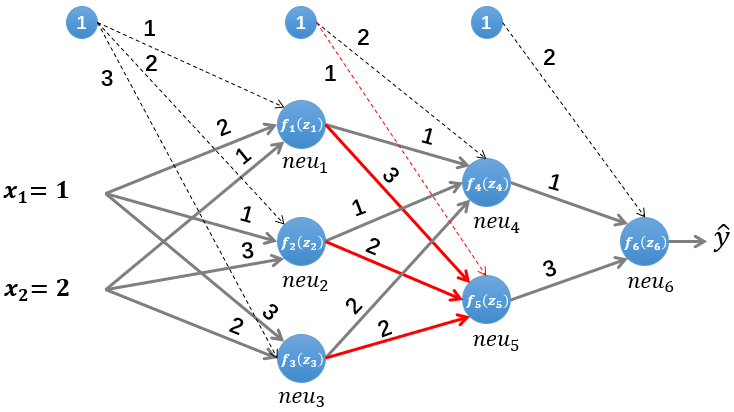

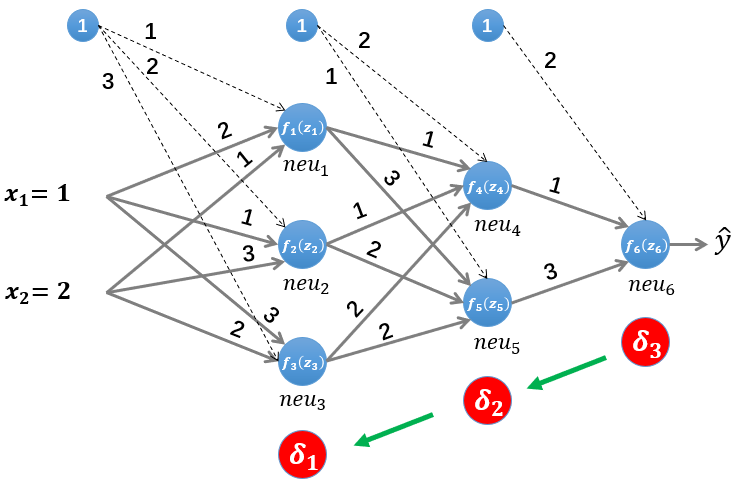

图1 一个简单的三层神经网络

图1所示是一个简单的三层(两个隐藏层,一个输出层)神经网络结构,假设我们使用这个神经网络来解决二分类问题,我们给这个网络一个输入样本 ,通过前向运算得到输出 。输出值 的值域为 ,例如 的值越接近0,代表该样本是“0”类的可能性越大,反之是“1”类的可能性大。

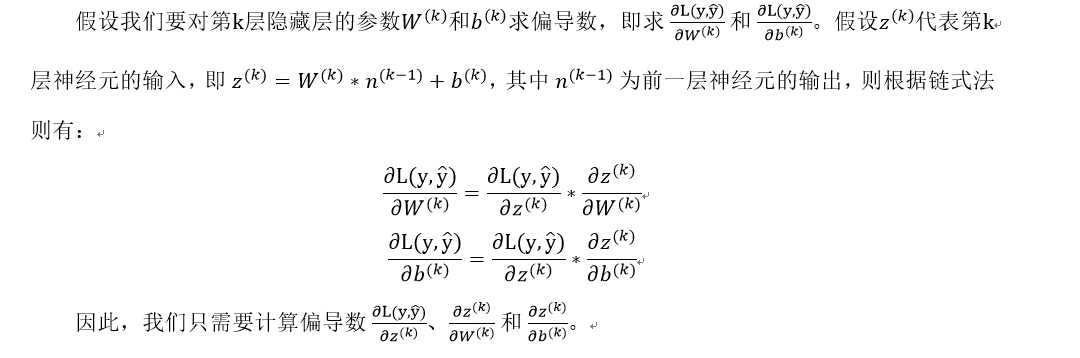

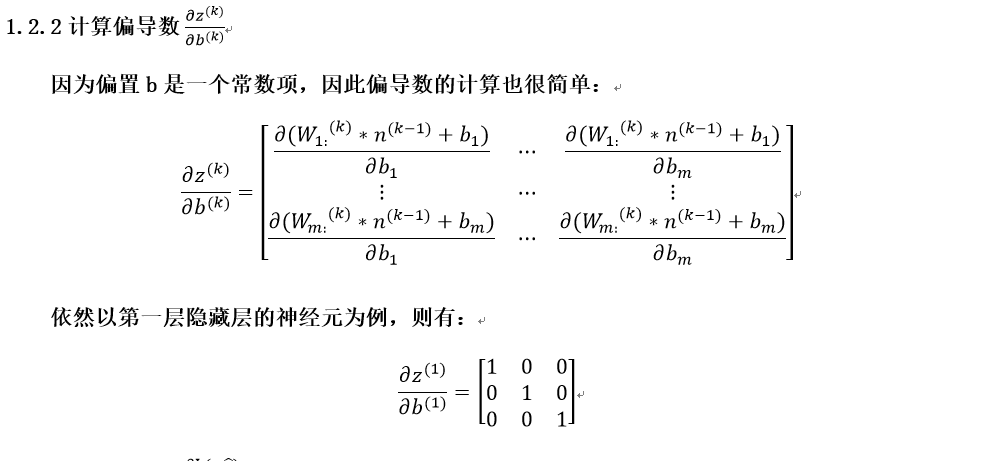

1.1前向传播的计算

为了便于理解后续的内容,我们需要先搞清楚前向传播的计算过程,以图1所示的内容为例:

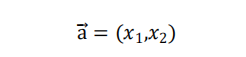

输入的样本为:

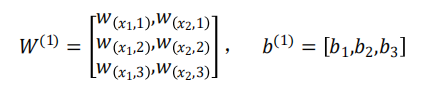

第一层网络的参数为:

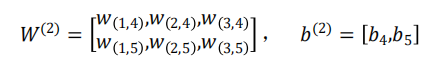

第二层网络的参数为:

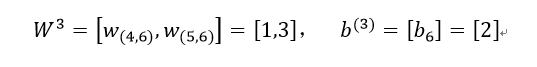

第三层网络的参数为:

1.1.1第一层隐藏层的计算

图2 计算第一层隐藏层

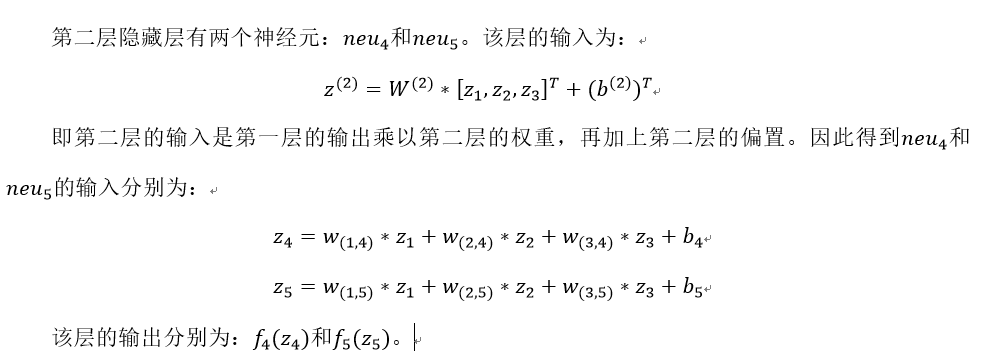

1.1.2第二层隐藏层的计算

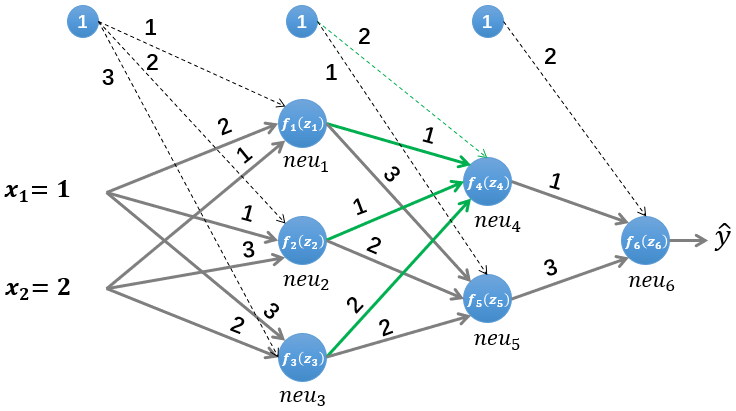

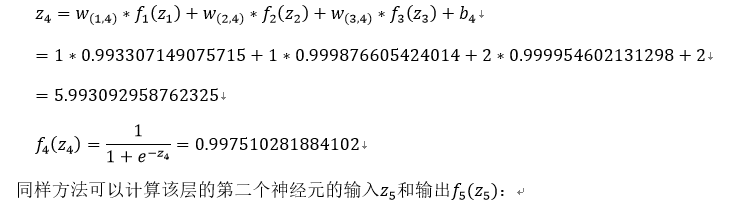

图3 计算第二层隐藏层

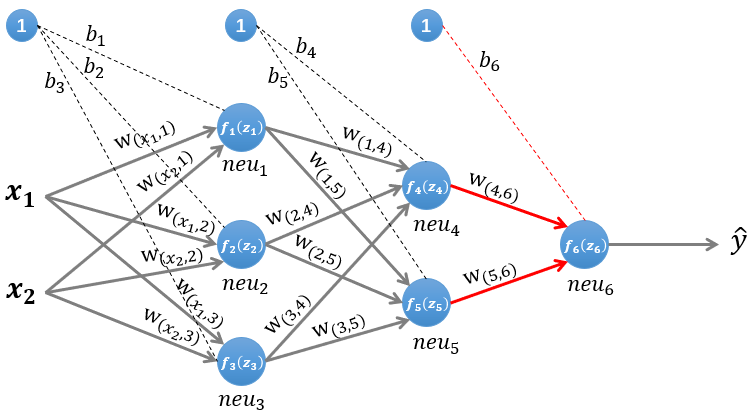

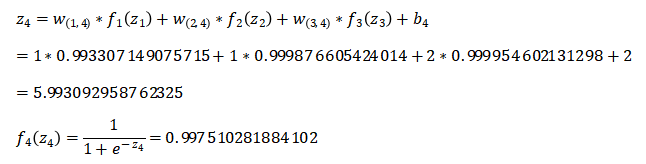

1.1.3输出层的计算

图4 计算输出层

![]()

![]()

即:

![]()

单纯的公式推导看起来有些枯燥,下面我们将实际的数据带入图1所示的神经网络中,完整的计算一遍。

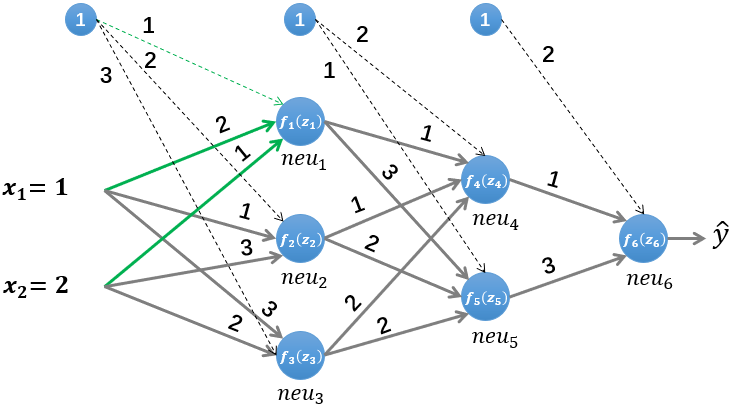

2.图解BP算法

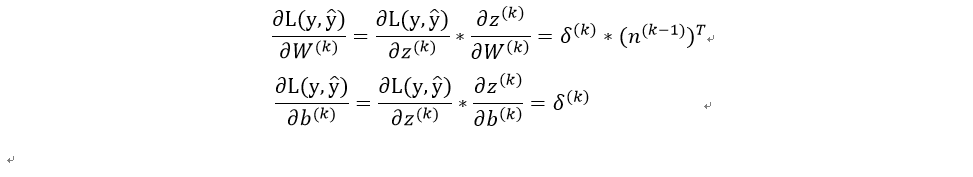

图5 图解BP算法

我们依然使用如图5所示的简单的神经网络,其中所有参数的初始值如下:

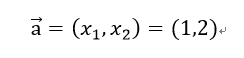

输入的样本为(假设其真实类标为“1”):

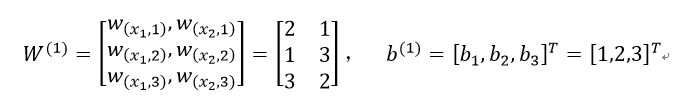

第一层网络的参数为:

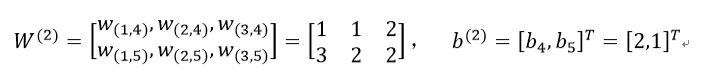

第二层网络的参数为:

第三层网络的参数为:

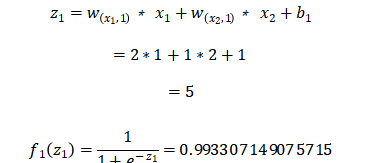

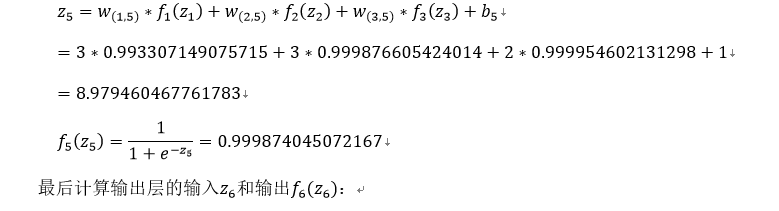

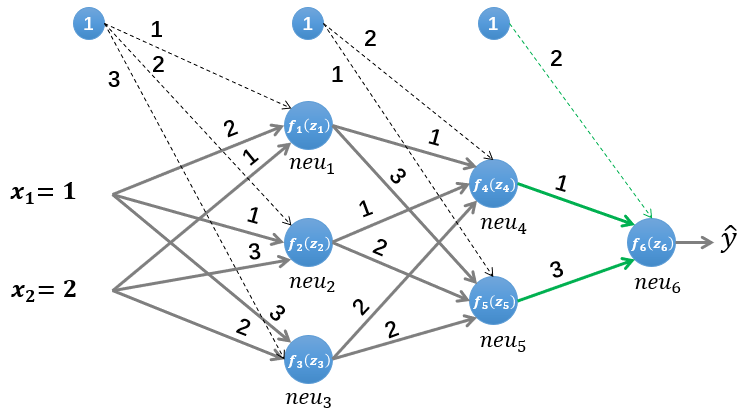

2.1前向传播

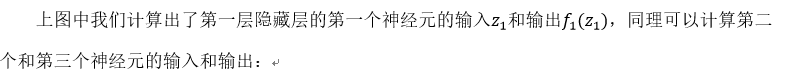

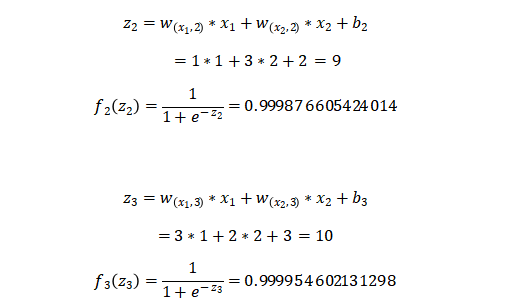

我们首先初始化神经网络的参数,计算第一层神经元:

![]()

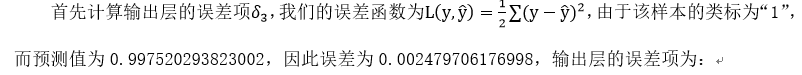

2.2误差反向传播

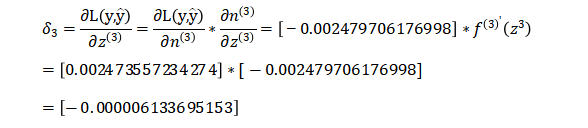

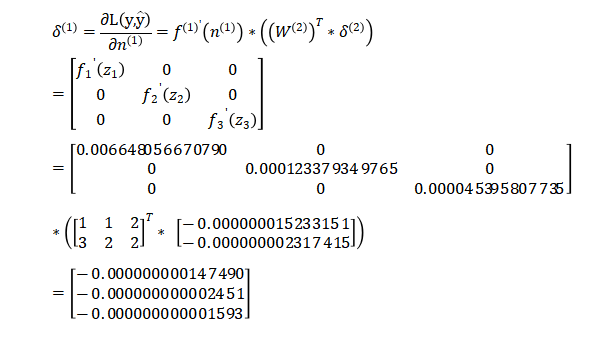

接着计算第二层隐藏层的误差项,根据误差项的计算公式有:

最后是计算第一层隐藏层的误差项:

最后是计算第一层隐藏层的误差项:

2.3更新参数

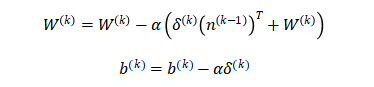

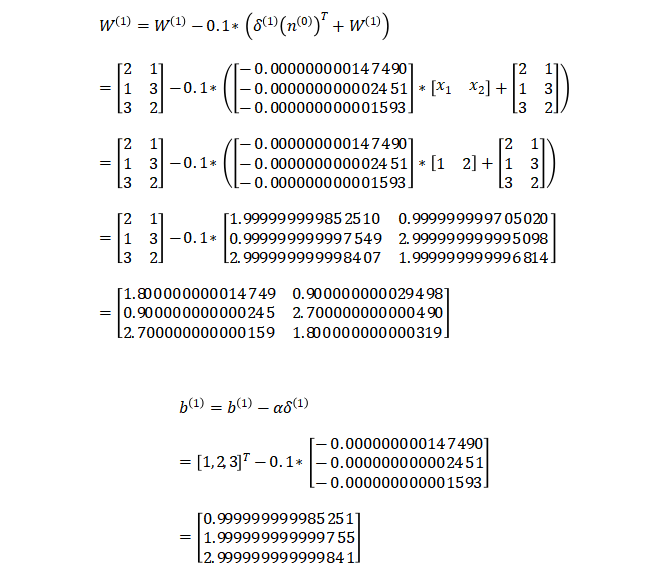

上一小节中我们已经计算出了每一层的误差项,现在我们要利用每一层的误差项和梯度来更新每一层的参数,权重W和偏置b的更新公式如下:

通常权重W的更新会加上一个正则化项来避免过拟合,这里为了简化计算,我们省去了正则化项。上式中的 是学习率,我们设其值为0.1。参数更新的计算相对简单,每一层的计算方式都相同,因此本文仅演示第一层隐藏层的参数更新:

3.小结

至此,我们已经完整介绍了BP算法的原理,并使用具体的数值做了计算。在下篇中,我们将带着读者一起亲手实现一个BP神经网络(不适用任何第三方的深度学习框架),敬请期待!有任何疑问,欢迎加入我们一起交流!

原创文章,作者:hlqfcee,如若转载,请注明出处:https://panchuang.net/2018/03/20/backpropagation-algorithm/