本文回顾了Google Research,Brain团队开发的EfficientDet:Scalable and EfficientObject Detection,(EfficientDet)。在本文中:

- 首先,提出了一种加权双向特征金字塔网络(BiFPN),实现了简单、快速的多尺度特征融合。

- 在此基础上,提出了一种复合缩放方法,可以同时对所有主干网络、特征网络和盒/类预测网络进行分辨率、深度和宽度的统一缩放。

- 最后,以EfficientNet为骨干,形成对象检测器家族EfficientDet,持续获得比现有技术更好的效率,如上所述。

这是一篇被引用600多篇的2020年度CVPR论文。(曾锡豪@Medium)Sik-Ho Tsang

大纲

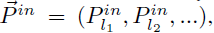

- 给定多比例功能列表:

- 其中pin_li表示级别li的特征。

- 目标是找到能够有效聚合不同特征并输出新特征列表的转换f:

- FPN采用3-7级输入功能:

- 例如,如果输入分辨率为640×640,则Pin_3表示分辨率为80×80(640/²³=80)的要素级别3,而Pin_7表示分辨率为5×5的要素级别7。

- 传统的FPN以自上而下的方式聚合多尺度特征:

- 其中,RESIZE通常是用于分辨率匹配的上采样或下采样操作。

- 最近,NAS-FPN采用神经结构搜索(NAS)来搜索更好的跨尺度特征网络拓扑。

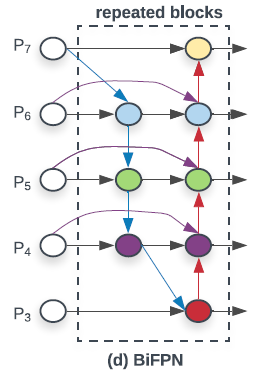

- 为了解决FPN问题,PANET添加了额外的自下而上路径聚合网络,如上文(B)所示。与NAS-FPN相比,网络更加规则。

2.双向特征金字塔网络(BiFPN)

- 首先,删除只有一条输入边的节点。直觉很简单:如果一个节点只有一条输入边,没有进行特征融合,那么它对以融合不同特征为目的的特征网络的贡献就会很小。这导致了简化的双向网络。

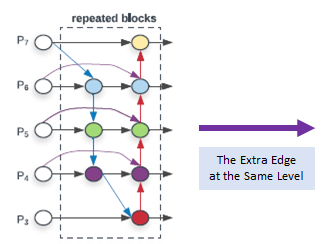

- 其次,如果原始输入到输出节点处于同一水平,则在它们之间增加一条额外的边,以便在不增加太多代价的情况下融合更多的特征。

- 第三,与只有一条自上而下和一条自下而上路径的PANET不同,每个双向(自上而下和自下而上)路径被视为一个要素网络层,并多次重复同一层,以实现更高级别的特征融合。

3.加权BiFPN

- 由于不同的输入要素具有不同的分辨率,因此它们对输出要素的贡献通常是不相等的。

- 为了解决这个问题,为每个输入增加了额外的权重,并让网络了解每个输入特征的重要性。

- 考虑了3种加权融合方法。

3.1.无界融合

- 其中wi是可学习权重,其可以是标量(每个特征)、向量(每个通道)或多维张量(每个像素)。

- 然而,由于标量权重是无界的,这可能会导致训练不稳定。需要有界范围。

3.2.基于SoftMax的融合

- 直观的想法是对每个权重应用Softmax,以便将所有权重归一化为值范围从0到1的概率。

- 然而,额外的Softmax会导致GPU硬件显著减速。

3.3。快速归一化融合

- 最后,采用快速归一化融合,其中通过在每个wi之后应用REU来确保wi≥为0。ε=0.0001是为了避免数值不稳定。

- 每个归一化权重的值也落在0到1之间,但由于这里没有Softmax操作,因此效率更高,在GPU上的运行速度最高可快30%。

- 例如,上面显示的BiFPN级别6的两个融合特征是:

- 其中PTD_6是自上而下路径上级别6的中间特征,而POUT_6是自下而上路径上级别6的输出特征。

- 值得注意的是,为了进一步提高效率,采用了深度可分离卷积进行特征融合。

- 在每次卷积之后添加批归一化和激活。

4.EfficientDet:网络架构

- 采用单级检测器范式。

- 采用预先训练好的ImageNet EfficientNet作为骨干网络。

- 提出的BiFPN作为特征网络,从骨干网络中提取3-7级特征{P3,P4,P5,P6,P7},反复进行自上而下和自下而上的双向特征融合。

- 这些融合的特征被馈送到类和盒网络,以分别产生对象类和包围盒预测。与RetinaNet类似,类和盒网络权重在所有级别的要素之间共享。

5.复合比例法

- 以前的工作通过使用更大的主干、更大的输入图像或堆叠更多的FPN层(即单因素缩放)来放大探测器。

- 最近,EfficientNet联合扩大了网络宽度、深度和输入分辨率的所有维度。

- 这里,EfficientDet提出了一种新的复合尺度目标检测方法,它使用一个简单的复合系数φ来联合放大骨干网、BiFPN网、类/盒网络和分辨率的所有维度。

4.1.主干网络

- 使用EfficientNet-B0到B6的相同宽度/深度缩放系数,使得可以使用ImageNet预先训练的检查点。

4.2.BiFPN网络

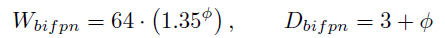

- 由于深度需要四舍五入为小整数,因此BiFPN深度D_bipn(层数)线性增加。

- BiFPN宽度W_bilpn(#个通道)与EfficientNet类似,呈指数增长。具体地说,对值列表{1.2,1.25,1.3,1.35,1.4,1.45}执行网格搜索,并选择最佳值1.35作为BiFPN宽度缩放因子。

- 形式上,BiFPN宽度和深度使用以下公式进行缩放:

4.3.盒/类预测网络

- 它们的宽度被固定为总是与BiFPN相同(即,W_pred=W_bilpn)。

- 深度(层数)使用公式线性增加:

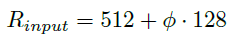

4.4.输入图像分辨率

- 由于在BiFPN中使用特征级别3-7,因此输入分辨率必须可以被2⁷=128整除,因此分辨率线性增加:

- (阅读EfficientNet可以更容易地理解这一部分。)

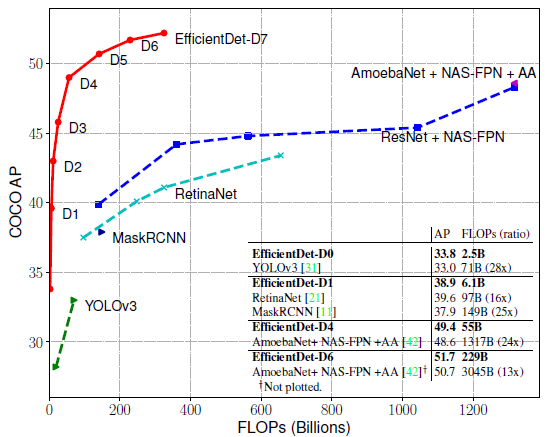

6.SOTA比较

- 上表将EfficientDet与其他物体探测器进行了比较,在没有测试时间增加的单一型号、单标度设置下。

- 测试了TEST-DEV(20K测试图像)和VAL(5K验证图像)的准确性。

- 与以前的探测器相比,EfficientDet实现了更高的效率,它比以前的探测器小4×-9×,并且在各种精度或资源限制下使用的触发器更少13×-42×。

- 在精度相对较低的情况下,EfficientDet-D0的精度与YOLOv3相当,FLOP减少28倍。

- 与RetinaNet[21]和Mask R-CNN[11]相比,我们的EfficientDet-D1实现了类似的精度,参数减少了8倍,FLOP减少了21倍。

- 在高精度条件下,EfficientDet的性能也始终优于最新的NAS-FPN[8]及其在[42]中的增强版本(即使用AutoAugment),其参数和FLOP要少得多。

- 特别是,EfficientDet-D7在TEST-DEV上实现了新的最先进的52.2 AP,在VAL上实现了51.8 AP的单模单刻度。

7.烧蚀研究

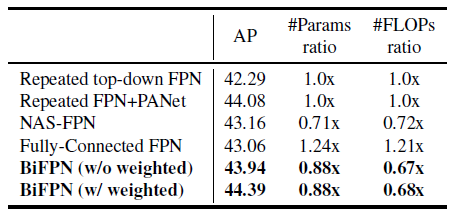

7.1.主干和BiFPN

- 基线采用RESNET+FPN。

- 然后用EfficientNet-B3替换主干,它以稍微少的参数和FLOP将精确度提高了约3AP。

- 虽然重复FPN+PANET比NAS-FPN获得了略高的精度,但它也需要更多的参数和触发器。

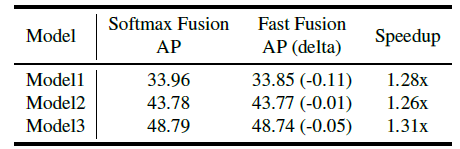

7.3.不同特征的融合

- 在EfficientDet-D3的BiFPN中随机选择3个节点。

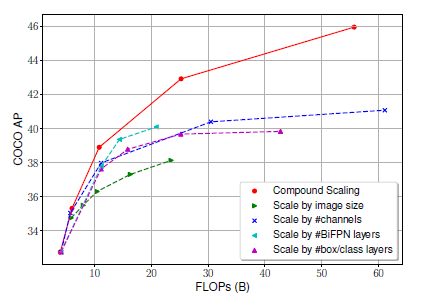

7.4.复合结垢

- 上图将建议的复合缩放与放大单个维度的分辨率/深度/宽度的其他替代方法进行了比较。

参考文献

[2020 CVPR][EfficientDet]EfficientDet:可伸缩高效的目标检测EfficientDet: Scalable and Efficient Object Detection

目标检测

2014:[OverFeat][R-CNN]2015:[FAST R-CNN][FASTER R-CNN][MR-CNN&S-CNN][DeepID-NET]2016:[OHEM][Craft][R-FCN][ION][MultiPathNet][Hikvision][GBD-NET/GBD-v1&GBD-v2][SSD][YOLOv1]2017:[NOC][G-RMI][TDM][DSSD[FPN][RetinaNet][DCN/DCNv1][Light-Head R-CNN][DSOD][CoupleNet]2018:[YOLOv3][Cascade R-CNN][MegDet][StairNet][RefineDet][CornerNet]2019年:[DCNv2][Reink ImageNet预培训][GRF-DSOD&GRF-SSD][Centernet][GridOverFeat R-CNN Fast R-CNN Faster R-CNN MR-CNN & S-CNN DeepID-Net OHEM CRAFT R-FCN ION MultiPathNet Hikvision GBD-Net / GBD-v1 & GBD-v2 SSD YOLOv1 NoC G-RMI TDM DSSD YOLOv2 / YOLO9000 FPN RetinaNet DCN / DCNv1 Light-Head R-CNN DSOD CoupleNet YOLOv3 Cascade R-CNN MegDet StairNet RefineDet CornerNet DCNv2 Rethinking ImageNet Pre-training GRF-DSOD & GRF-SSD CenterNet Grid R-CNN NAS-FPN EfficientDet

我以前的其他论文阅读

原创文章,作者:fendouai,如若转载,请注明出处:https://panchuang.net/2021/07/30/%e5%9b%9e%e9%a1%be%e2%80%8a-%e2%80%8aefficientdet%ef%bc%9a%e5%8f%af%e6%89%a9%e5%b1%95%e4%b8%94%e9%ab%98%e6%95%88%e7%9a%84%e5%af%b9%e8%b1%a1%e6%a3%80%e6%b5%8b/