多重信号辅助音频分离,让你在嘈杂环境也能指哪听哪儿

来源 | Tensorflow

出品 | 磐创AI技术团队

【磐创AI导读】:本文授权转载自Tensorflow,主要介绍了嘈杂环境下的音频处理技术。欢迎大家点击上方蓝字关注我们的公众号:磐创AI。

博客发布人:Google Research 软件工程师 Inbar Mosseri 和 Oran Lang

在嘈杂的环境中,人们非常善于把注意力集中在某个特定的人身上,在心理上”屏蔽”所有其他语音和声音。这种能力被称为鸡尾酒会效应,它是我们人类与生俱来的本领。然而,尽管关于自动语音分离(将音频信号分离为单独的语音源)的研究已经非常深入,这个课题仍是计算机领域的一项重大挑战。

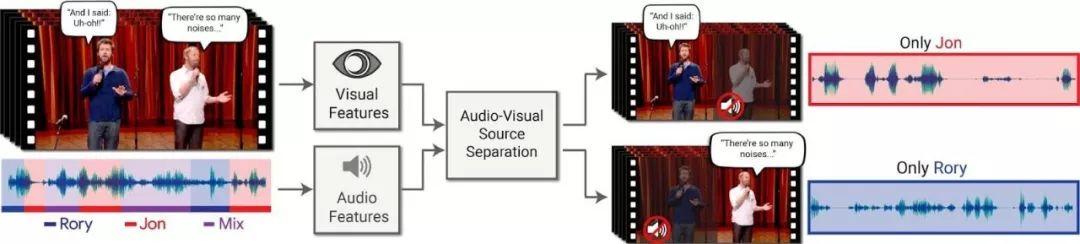

在”Looking to Listen at the Cocktail Party”论文中,我们提出了一种深度学习音频—视觉模型,用于将单个语音信号与背景噪声、其他人声等混合声音分离开来。我们通过计算生成视频,增强其中特定人员的语音,同时减弱其他人的声音。此方法用在具有单个音频轨道的普通视频上,用户需要做的就是在视频中选出他们想要听到的说话者的面部,或者结合语境用算法选出这样的人。我们认为此方法用途广泛,从视频中的语音增强和识别、视频会议,到改进助听器,不一而足,尤其适用于有多个说话人的情景。

这项技术的独特之处在于结合了输入视频的听觉和视觉信号来分离语音。直观地讲,人嘴部的运动应当与这个人说话时产生的声音相关联,这反过来又可以帮助识别音频的哪些部分对应于这个人。视觉信号不仅可以在混合语音的情况下显著提高语音分离质量(与仅仅使用音频的语音分离相比,与我们的论文得出的结论相同),但是重要的是,它还能够将分离的干净语音轨道与视频中的可见说话者相关联。

在我们的方法中,输入是具有一个或多个说话者的视频,其中我们需要的语音受到其他说话者和(或)背景噪声的干扰。输出是输入音频轨道分解成的干净语音轨道,其中每个语音轨道来自视频中检测到的每一个人。

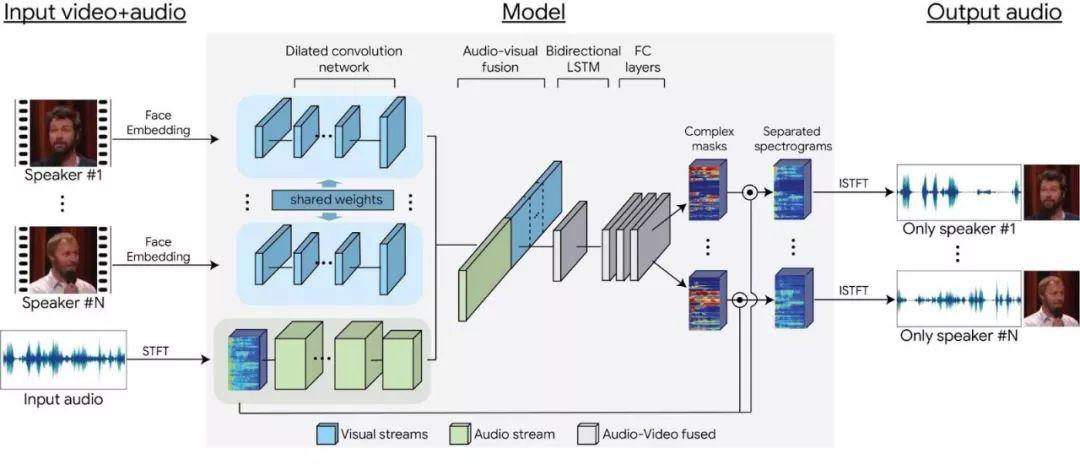

音频—视觉语音分离模型

为了生成训练样本,我们首先从 YouTube 上采集了 10 万个高质量讲座和演讲视频。然后从视频中提取带有清晰语音的片段(例如没有混合音乐、观众声音或其他说话者声音的片段)和视频帧中只有一个说话者的片段。这样得到了大约 2000 小时的视频剪辑,镜头中出现的是单个人,且说话的时候没有背景干扰。之后,我们使用这些干净数据生成”合成鸡尾酒会”,即,将人脸视频、来自单独视频源的对应语音及从 AudioSet 获取的无语音背景噪声混合在一起。

使用这些数据,我们能够训练基于多流卷积神经网络的模型,将合成鸡尾酒会混合片段分割成视频中每个说话者的单独音频流。网络输入是从每一帧检测到的说话者脸部缩略图中提取的视觉特征以及视频声道的声谱图表示。在训练过程中,网络(分别)学习视觉和听觉信号的编码,然后将其融合在一起,形成一个联合音频—视觉表示。利用这种联合表示,网络可以学习为每个说话者输出时频掩码。输出掩码乘以带噪声的输入声谱图,然后转换成时域波形,以获取每位说话者单独、干净的语音信号。如需了解完整的详细信息,请参阅我们的论文,论文链接:

https://arxiv.org/abs/1804.03619

基于多流神经网络的模型架构。

以下是使用我们的方法得到的语音分离和增强结果(先播放带混合或嘈杂语音的输入视频,然后播放增强结果)。所选说话者之外的另一个人的声音可以完全消去,或被抑制到所需的音量级别。

在语音识别中的应用

我们的方法也可以作为预处理程序应用于语音识别和自动视频字幕添加。处理语音重叠的说话者对于自动字幕添加系统来说很有挑战性,将音频分离为不同的来源可以帮助生成更加准确、易读的字幕。

点击播放上面视频,小编已经为你准备好带有 YouTube 自动字幕的视频。

我们的项目网页提供了更多结果,以及此技术与最先进的纯音频语音分离和近期其他视听语音分离工作的对比情况。事实上,随着深度学习领域近期不断取得进展,学术界对视听分析的关注显著增加。在我们进行本研究的同时,其他机构也纷纷进行了不同的研究,例如,加州大学伯克利分校的一项研究分析了如何使用自我监督的方法来分离画面内/外说话者的语音,MIT 的一项研究则解决了如何分离屏幕上多个物体(例如乐器)的声音,同时定位发出声音的图像区域这一问题。

我们认为这项技术的应用前景十分广阔。我们目前正在探索如何将此技术整合到各种 Google 产品中。敬请期待!

Looking to Listen 项目网页:

https://looking-to-listen.github.io/

致谢

本文介绍的研究由 Ariel Ephrat(实习生)、Inbar Mosseri、Oran Lang、Tali Dekel、Kevin Wilson、Avinatan Hassidim、Bill Freeman 和 Michael Rubinstein 共同完成。我们要感谢 Yossi Matias 和 Google Research Israel 对项目的支持,以及 John Hershey 提供的宝贵意见。我们还要感谢 Arkady Ziefman 在动画和人物方面提供的帮助,感谢 Rachel Soh 帮助我们获取文中所用视频内容的权限。

你也许还想看:

● 一文彻底搞懂BP算法:原理推导+数据演示+项目实战(上篇)

● TensorFlow + Keras 实战 YOLO v3 目标检测图文并茂教程(文末有惊喜)

● 入门 | Tensorflow实战讲解神经网络搭建详细过程

Tips:欢迎大家点击最下方二维码关注我们的公众号,点击干货资源专栏或发送关键字“资源”获取更多资源推荐。关注我们的历史文章,一起畅游在深度学习的世界中。我们期待你的留言和投稿,共建交流平台。来稿请寄:voice1235@163.com。

欢迎扫码进入相应技术交流群:

点击下方 | 阅读原文 | 了解更多

点击下方 | 阅读原文 | 了解更多

原创文章,作者:fendouai,如若转载,请注明出处:https://panchuang.net/2018/05/26/f73c4108f8/